Британские ученые обучили ИИ трансформировать устную речь в видео с виртуальным сурдопереводчиком. Алгоритм самостоятельно оценивает качество работы. Нейросеть поможет людям с частичной или полной потерей слуха улучшить восприятие контента и свободнее чувствовать себя на публичных мероприятиях.

В мире десятки миллионов глухих и слабослышащих людей, использующих жестовый язык как основное средство коммуникации. С одной стороны, в онлайн-мире проблема общения для слабослышащих людей решается при помощи субтитров. Но с другой — популярные сейчас вебинары, стримы и прочий контент приходится переводить на жестовый язык в режиме реального времени. Ученые давно исследуют эту проблему и ищут решение.

Сейчас исследователи смотрят в сторону нейротехнологий. В Университете Суррея разработчики создали алгоритм сурдоперевода нового поколения. ИИ преобразует устную речь в движения человеческого скелета. Затем скелету придают человеческий облик, и создается реалистичный видеоряд. С помощью технологии можно изготавливать видео и на основе текста.

К чему такие сложности и почему важно движение всего скелета? Язык жестов — это не только знаки руками, в нем задействованы все части тела и даже мимика. Технологии, которые использовались ранее, часто генерировали размытые модели, что приводило к искажению смыслов или вовсе непониманию речи виртуального сурдопереводчика.

Фото: ru.freepik.com

Как устроена новая нейросеть

В основе алгоритма следующее: принимающий сигнал поступает в виде аудио, затем преобразуется в схематичную модель человеческого скелета, воспроизводящего соответствующими жестами речь. После этого последовательность поз подается сверточной нейросети U-Net. Сеть преобразует движения и позы в реалистичное видео.

Чтобы добиться высоких результатов, ученые обучали нейросеть по видео реальных переводчиков жестового языка.

Для оценки получившейся модели разработчики провели эксперименты с участием добровольцев. Так, они попросили их сравнить новый метод с другими ранее используемыми способами трансформации речи. Из 46 человек — 13 являлись носителями языка жестов. Сравнение проходило по четырем параметрам, по каждому из которых новый алгоритм обошел по качеству предыдущие версии.

Не только британские ученые

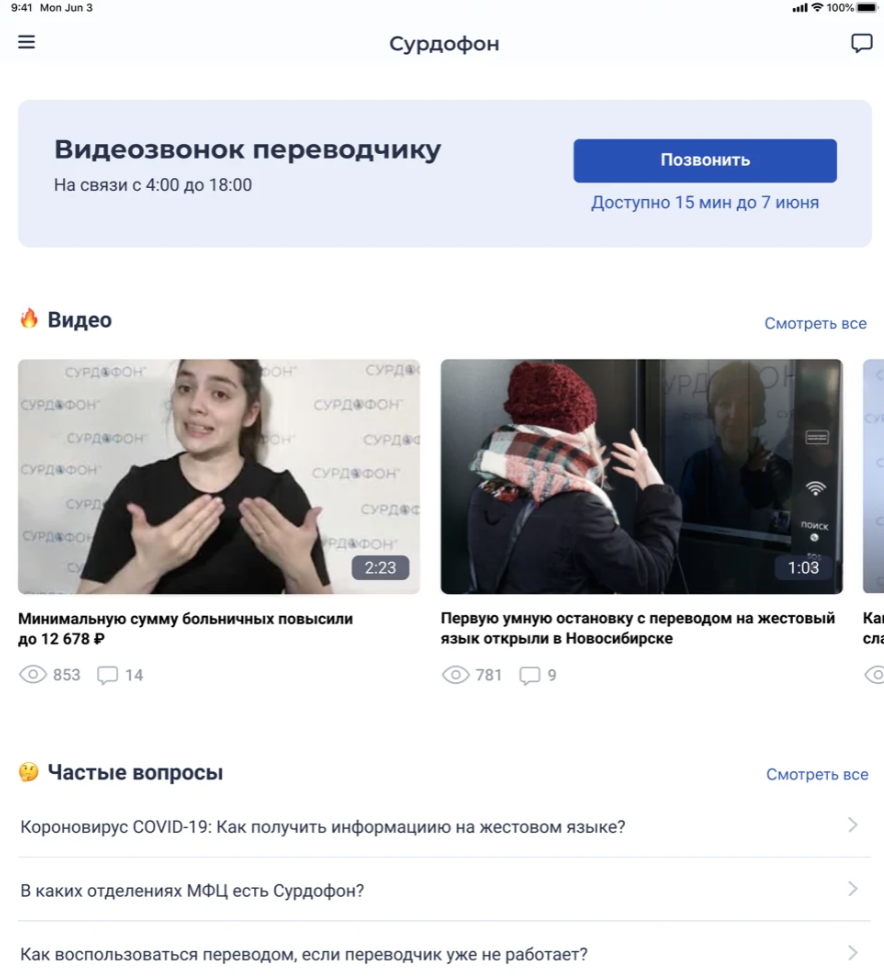

Исследователи с начала века ведут разработки в области сурдоперевода. Один из самых известных продуктов — анимированный виртуальный переводчик от IBM. Но проект не получил развития. Несколько лет спустя его реинкарнировали в Новосибирске. Программа, придуманная учеными из Новосибирского академгородка, распознает речь, анализирует смысл и переводит на жестовый язык. Потом аватар показывает текст на экране.

В то время считали, что разработка станет такой же популярной, как Google Translator. Сейчас протестировать программу можно в приложении «Адаптис» для AppStore и Google Play.

Несколько лет назад бельгийские ученые напечатали 3D-руку под управлением Arduino, которая также функционирует как сурдопереводчик. Проект назвали ASLAN. Рука состояла из 25 отдельных деталей из PLA-пластика. В перспективе к ней намеревались добавить еще одну руку и роботизированное лицо для передачи эмоций.

Перевод с языка жестов на привычный нам язык также представляет большие трудности. Российские ученые из Института проблем управления им. В.А. Трапезникова РАН (ИПУ РАН) несколько лет назад начали разработку подобного ИИ. Предполагалось, что в будущем он поможет перевести жесты в слова, фразы и буквы. Ученые тогда сообщили, что на создание алгоритма может уйти не один год.

Российская программа будет базироваться на площадке, созданной слабослышащей сотрудницей ИПУ РАН. Она несколько лет развивает сайт «Сурдосервер». Тогда же сообщалось, что российские ученые работают над мобильным приложением «Сурдосервис» и сурдооблаком для обмена информацией слабослышащими людьми.