АКТУАЛЬНОСТЬ ТЕМЫ

В предыдущих обзорах (https://habr.com/ru/articles/690414/, https://habr.com/ru/articles/695556/) мы рассматривали линейную регрессию. Пришло время переходить к нелинейным моделями. Однако, прежде чем рассматривать полноценный нелинейный регрессионный анализ, остановимся на аппроксимации зависимостей.

Про аппроксимацию написано так много, что, кажется, и добавить уже нечего. Однако, кое-что добавить попытаемся.

При выполнении анализа данных может возникнуть потребность оперативно построить аналитическую зависимость. Подчеркиваю - речь не идет о полноценном регрессионном анализе со всеми его этапами, проверкой гипотез и т.д., а только лишь о подборе уравнения и оценке ошибки аппроксимации. Например, мы хотим оценить характер зависимости между какими-либо показателями в датасете и принять решение о целесообразности более глубокого исследования. Подобный инструмент предоставляет нам тот же Excel - все мы помним, как добавить линию тренда на точечном графике:

Такой же инструмент необходим и при работе в Python, причем желательно, сохранив главное достоинство - оперативность и удобство использования, избавиться от недостатков, присущих Excel:

ограниченный набор аналитических зависимостей и метрик качества аппроксимации;

невозможность построения нескольких зависимостей для одного набора данных;

невозможность установления ограничений на значения параметров зависимостей;

невозможность устранить влияние выбросов.

Использованием подобных инструментов мы и рассмотрим в данном обзоре.

Применение пользовательских функций

Как и в предыдущих обзорах, здесь будут использованы несколько пользовательских функций для решения разнообразных задач. Все эти функции созданы для облегчения работы и уменьшения размера программного кода. Данные функции загружается из пользовательского модуля my_module__stat.py, который доступен в моем репозитории на GitHub (https://github.com/AANazarov/MyModulePython).

Вот перечень данных функций:

graph_lineplot_sns - функция позволяет построить линейный график средствами seaborn и сохранить график в виде png-файла;

graph_scatterplot_sns - функция позволяет построить точечную диаграмму средствами seaborn и сохранить график в виде png-файла;

regression_error_metrics - функция возвращает ошибки аппроксимации регрессионной модели;

Пользовательскую функцию simple_approximation мы создаем в процессе данного обзора (она тоже включена в пользовательский модуль my_module__stat.py).

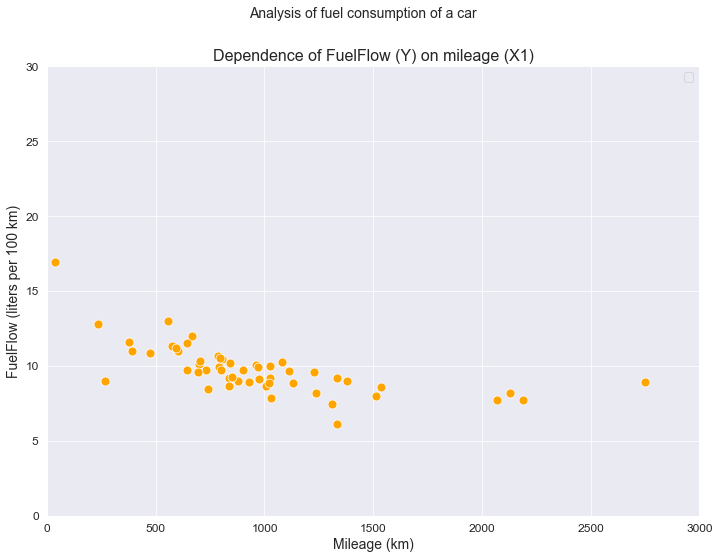

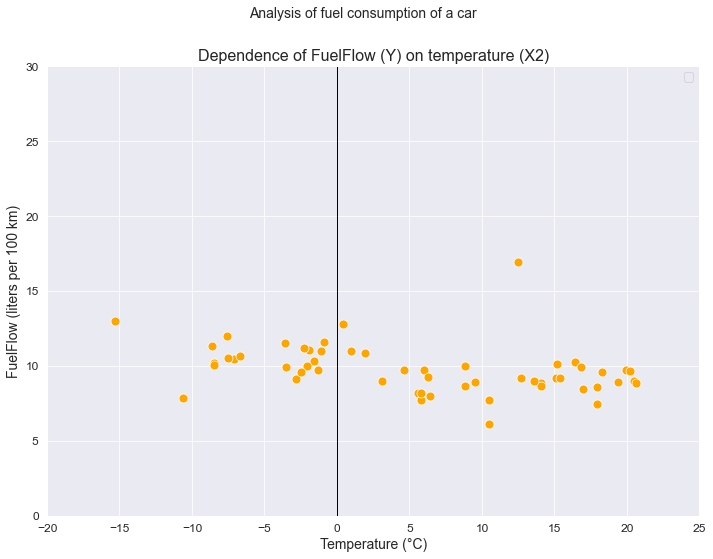

ИСХОДНЫЕ ДАННЫЕ

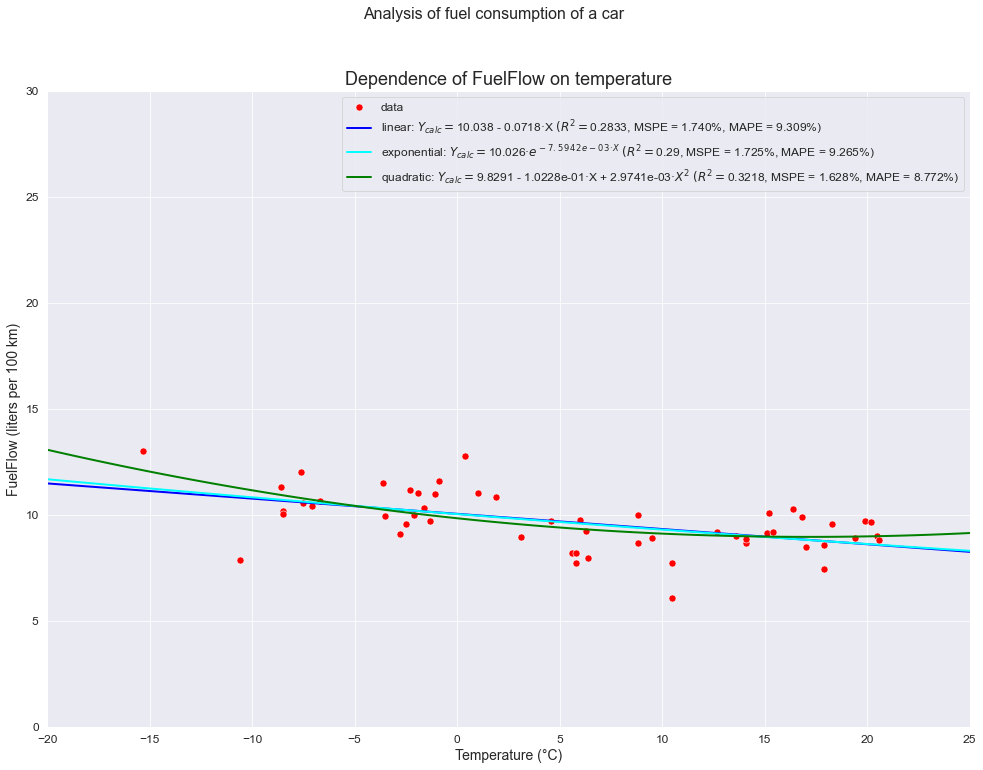

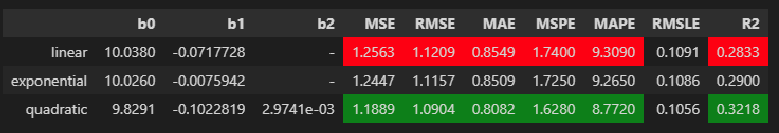

В качестве примера в данном обзоре продолжим рассматривать задачу нахождения зависимости среднемесячного расхода топлива автомобиля (л/100 км) (FuelFlow) от среднемесячного пробега (км) (Mileage) и среднемесячной температуры (Temperature) (этот же датасет я использовал в своих статьях: https://habr.com/ru/post/683442/, https://habr.com/ru/post/695556/).

# Общий заголовок проекта

Task_Project = "Analysis of fuel consumption of a car"

# Заголовок, фиксирующий момент времени

AsOfTheDate = ""

# Заголовок раздела проекта

Task_Theme = ""

# Общий заголовок проекта для графиков

Title_String = f"{Task_Project}\n{AsOfTheDate}"

# Наименования переменных

Variable_Name_T_month = "Monthly data"

Variable_Name_Y = "FuelFlow (liters per 100 km)"

Variable_Name_X1 = "Mileage (km)"

Variable_Name_X2 = "Temperature (°С)"Загрузим исходные данные из csv-файла. Это уже обработанный датасет, готовый для анализа (первичная обработка данных выполненная в отдельном файле Preparation of input data.py, который также доступен в моем репозитории на GitHub).

Столбцы таблицы:

Month — месяц (в формате Excel)

Mileage - месячный пробег (км)

Temperature - среднемесячная температура (°C)

FuelFlow - среднемесячный расход топлива (л/100 к

dataset_df = pd.read_csv(filepath_or_buffer='data/dataset_df.csv', sep=';')Сохранение данных

Сохраняем данные в виде отдельных переменных (для дальнейшего анализа).

Среднемесячный расход топлива (л/100 км) / Fuel Flow (liters per 100 km):

Y = np.array(dataset_df['Y'])Пробег автомобиля за месяц (км) / Mileage (km):

X1 = np.array(dataset_df['X1'])Среднемесячная температура (°С) / Temperature (degrees celsius):

X2 = np.array(dataset_df['X2'])Визуализация

Границы значений переменных (при построении графиков):

(X1_min_graph, X1_max_graph) = (0, 3000)

(X2_min_graph, X2_max_graph) = (-20, 25)

(Y_min_graph, Y_max_graph) = (0, 30)Построение графика:

graph_scatterplot_sns(

X1, Y,

Xmin=X1_min_graph, Xmax=X1_max_graph,

Ymin=Y_min_graph, Ymax=Y_max_graph,

color='orange',

title_figure=Title_String, title_figure_fontsize=14,

title_axes='Dependence of FuelFlow (Y) on mileage (X1)', title_axes_fontsize=16,

x_label=Variable_Name_X1,

y_label=Variable_Name_Y,

label_fontsize=14, tick_fontsize=12,

label_legend='', label_legend_fontsize=12,

s=80)

ОСНОВЫ ТЕОРИИ

Кратко остановимся на некоторых теоретических вопросах.

Инструменты Python для аппроксимации

Python предоставляет нам большой набор инструментов для аппроксимации (подробнее см. https://docs.scipy.org/doc/scipy/reference/optimize.html). Мы остановимся на некоторых из них:

функция scipy.optimize.leastsq (https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.leastsq.html#scipy.optimize.leastsq)

функция scipy.optimize.least_squares (https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.least_squares.html#scipy.optimize.least_squares)

функция scipy.optimize.curve_fit (https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.curve_fit.html)

функция scipy.optimize.minimize (https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.minimize.html#scipy.optimize.minimize)

библиотека lmfit (https://lmfit.github.io/lmfit-py/)

Основные виды моделей для аппроксимации

Не будем углубляться в классификацию моделей, об этом написаны сотни учебников, монографий, справочников и статей. Однако, в целях унификации в таблице ниже все-таки приведем основные виды моделей для аппроксимации - разумеется, это список не является исчерпывающим, но охватывает более или менее достаточный набор моделей для практического использования:

Наименование | Уравнение |

|---|---|

линейная |

|

квадратическая | |

кубическая | |

полиномиальная | |

степенная | |

экспоненциальная I типа | |

экспоненциальная II типа | |

логарифмическая | |

обратная логарифмическая | |

гиперболическая I типа | |

гиперболическая II типа | |

гиперболическая III типа | |

логистическая кривая I типа | |

логистическая кривая II типа (Перла-Рида) | |

кривая Гомперца | |

модифицированная экспонента I типа | |

модифицированная экспонента II типа | |

обобщенная логистическая кривая I типа | |

обобщенная логистическая кривая II типа |

Примечания:

Нелинейные модели в ряде источников принято делить на 2 группы:

модели, нелинейные по факторам - путем замены переменных могут быть линеаризованы, т.е. приведены к линейному виду, и для оценки их параметров может применяться классический метод наименьших квадратов;

модели, нелинейные по параметрам - не могут быть линеаризованы, и для оценки их параметров необходимо применять итерационные методы.

К моделям, нелинейным по параметрам, относятся, например, модифицированные кривые (модифицированная экспонента, обобщенная логистическая кривая), кривая Гомперца и пр. Оценка их параметров средствами Python требует особых приемов (предварительная оценка начальных значений). В данном разборе мы не будем особо останавливаться на этих моделях.

Экспоненциальные модели могут быть выражены в 2-х формах:

с помощью собственно экспоненциальной функции

;

в показательной форме

Не будем особо распространяться на опасности увлечения полиномиальными моделями для аппроксимации данных, отметим только, что использовать такие модели нужно очень осторожно, с особым обоснованием и содержательным анализом задачи, а полиномы выше 3-й степени вообще использовать не рекомендуется.

Метрики качества аппроксимации

Рассмотрим основные метрики качества:

Mean squared error (MSE) - среднеквадратическая ошибка и Root mean square error (RMSE) - квадратный корень из среднеквадратической ошибки MSE:

Особенности: тенденция к занижение качества модели, чувствительность к выбросам.

2. Mean absolute error (MAE) - средняя абсолютная ошибка:

Особенность: гораздо менее чувствительна к выбросам, чем RMSE.

3. Mean squared prediction error (MSPE) - среднеквадратическая ошибка прогноза (среднеквадратическая ошибка в процентах):

Особенности: нечувствительность к выбросам; нельзя использовать для наблюдений, в которых значения выходной переменной равны нулю.

4. Mean absolute percentage error (MAPE) - средняя абсолютная ошибка в процентах:

Особенности: нельзя использовать для наблюдений, в которых значения выходной переменной равны нулю.

5. Root Mean Square Logarithmic Error (RMSLE) - cреднеквадратичная логарифмическая ошибка, применяется, если разность между фактическим и предсказанным значениями различается на порядок и выше:

Особенности: нечувствительность к выбросам; смещена в сторону меньших ошибок (наказывает больше на недооценку, чем за переоценку); к значениям добавляется константа 1, так как логарифм 0 не определен.

6.

- коэффициент детерминации:

Особенность: значение

находится в пределах [0; 1], но иногда может принимать отрицательные значения (если ошибка модели больше ошибки среднего значения).

Разумеется, приведенный перечень метрик качества аппроксимации не является исчерпывающим.Сравнительный анализ метрик качества приведен в https://machinelearningmastery.ru/how-to-select-the-right-evaluation-metric-for-machine-learning-models-part-1-regrression-metrics-3606e25beae0/, https://machinelearningmastery.ru/how-to-select-the-right-evaluation-metric-for-machine-learning-models-part-2-regression-metrics-d4a1a9ba3d74/, https://loginom.ru/blog/quality-metrics.

Оценка ошибок и доверительных интервалов для параметров моделей аппроксимации

Инструменты аппроксимации Python позволяют получить довольно обширный набор различных данных, в том числе тех, которые нам дают возможность оценить ошибки параметров аппроксимации и построить для них доверительные интервалы. Не вдаваясь глубоко в математическую теорию вопроса, кратко разберем, как это реализовать на практике.

В общем виде доверительный интервал для параметров аппроксимации можно представить в виде

, где

- значение j-го параметра модели, а

- стандартная ошибка этого параметра.

Для определения

нам необходима матрица ковариации оценок параметров

, диагональные элементы которой представляют собой дисперсию оценок параметров, то есть:

имеет размерность

, где

- число оцениваемых параметров модели аппроксимации.

Теперь разберем, как получить

, используя различные инструменты аппроксимации Python:

Функция scipy.optimize.curve_fit в стандартном наборе возвращаемых данных непосредственно содержит расчетную ковариационную матрицу

(The estimated covariance of popt), которая обозначается в программном коде как pcov (см. https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.curve_fit.html). Расчетная стандартная ошибка параметров может быть определена очень просто: perr = np.sqrt(np.diag(pcov)).

Функция scipy.optimize.leastsq в стандартном наборе возвращаемых данных содержит матрицу, обратную матрице Гессе (The inverse of the Hessian)

, которая обозначается в программном коде как cov_x. Чтобы получить

, необходимо умножить

на величину остаточной дисперсии

:

или в программном коде: pcov = cov_x*MSE.

Величина SSE, необходимая для расчета MSE, может быть определена в программном коде как

.

Функция scipy.optimize.least_squares вместо

возвращает модифицированную матрицу Якоби (Modified Jacobian matrix)

, которая обозначается в программном коде как result.jac (см. https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.least_squares.html#scipy.optimize.least_squares, https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.OptimizeResult.html#scipy.optimize.OptimizeResult). Получить

можно следующим образом:

или в программном коде: cov_x = np.linalg.inv(np.dot(result.jac.T, result.jac)).

Функция scipy.optimize.minimize имеет свои специфические особенности: возвращает обратную матрицу Гессе (Inverse of the objective function’s Hessian), которая обозначается в программном коде как res.hess_inv (см. https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.minimize.html#scipy.optimize.minimize, https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.OptimizeResult.html#scipy.optimize.OptimizeResult), но для определения cov_x необходимо воспользоваться приближенным выражением cov_x = 2*res.hess_inv (подробнее об этом см. https://stackoverflow.com/questions/40187517/getting-covariance-matrix-of-fitted-parameters-from-scipy-optimize-least-squares).

Библиотека lmfit позволяет непосредственно в стандартном наборе возвращаемых данных получить ошибки и доверительные интервалы параметров аппроксимации.

Более подробно с вопросом можно ознакомиться здесь:

https://question-it.com/questions/9466217/poluchenie-kovariatsionnoj-matritsy-podobrannyh-parametrov-iz-metoda-scipy-optimizeleast_squares

https://stackoverflow.com/questions/40187517/getting-covariance-matrix-of-fitted-parameters-from-scipy-optimize-least-squares

https://stackoverflow.com/questions/14854339/in-scipy-how-and-why-does-curve-fit-calculate-the-covariance-of-the-parameter-es

https://stackovergo.com/ru/q/4167751/in-scipy-how-and-why-does-curvefit-calculate-the-covariance-of-the-parameter-estimates

https://math.stackexchange.com/questions/2349026/why-is-the-approximation-of-hessian-jtj-reasonable

https://mmas.github.io/least-squares-fitting-numpy-scipy

https://www.nedcharles.com/regression/Nonlinear_Least_Squares_Regression_For_Python.html

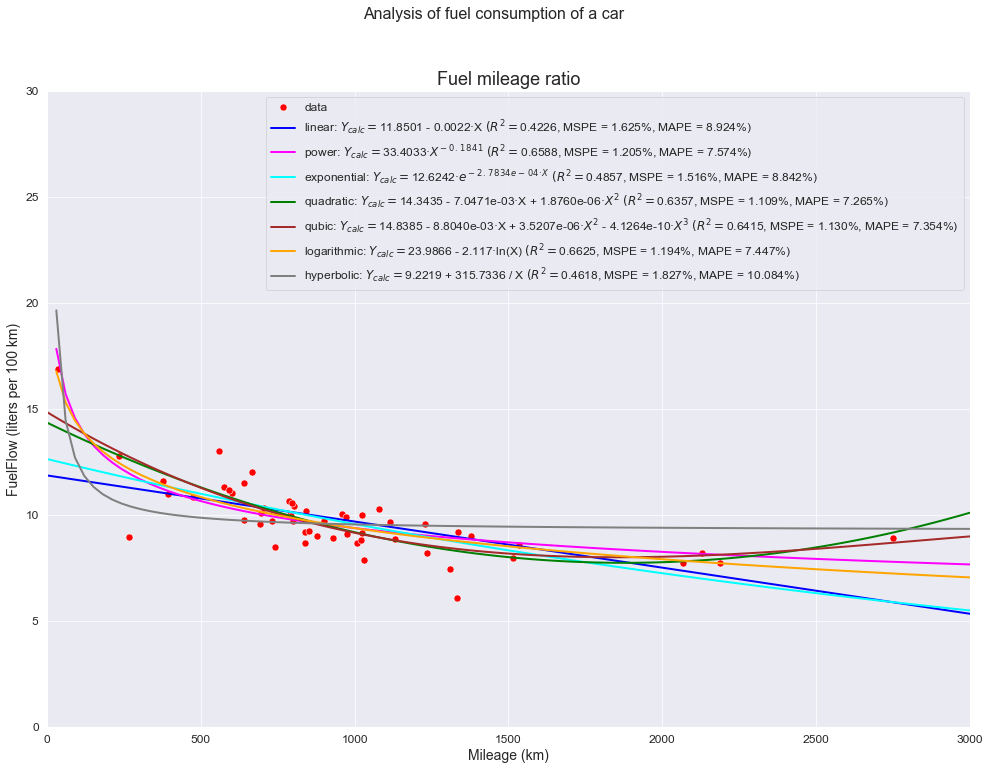

АППРОКСИМАЦИЯ ЗАВИСИМОСТЕЙ

Определим набор зависимостей, которые будем использовать для аппроксимации. В данном обзоре мы рассмотрим набор наиболее широко распространенных зависимостей, не требующих особого подхода к вычислениям. Более сложные случаи - например, зависимости с асимптотами, зависимости нелинейные по параметрам и пр. - тема для отдельного рассмотрения.

# equations

linear_func = lambda x, b0, b1: b0 + b1*x

quadratic_func = lambda x, b0, b1, b2: b0 + b1*x + b2*x**2

qubic_func = lambda x, b0, b1, b2, b3: b0 + b1*x + b2*x**2 + b3*x**3

power_func = lambda x, b0, b1: b0 * (x**b1)

exponential_type_1_func = lambda x, b0, b1: b0*np.exp(b1*x)

exponential_type_2_func = lambda x, b0, b1: b0*np.power(b1, x)

logarithmic_func = lambda x, b0, b1: b0 + b1*np.log(x)

hyperbolic_func = lambda x, b0, b1: b0 + b1/xДалее будем собственно выполнять аппроксимацию: оценивать параметры моделей, строить графики, причем так, чтобы на графиках отображались уравнения моделей и метрики качества (по аналогии с тем, как это позволяет сделать Excel - это очень удобно), рассмотрим возможность определения ошибок и доверительных интервалов для параметров аппроксимации.

Отдельно довольно кратко остановимся на библиотеке lmfit, которая предоставляет очень широкий инструментарий для аппроксимации.

Аппроксимация с использованием scipy.optimize.leastsq

Особенности использования функции:

Реализация метода наименьших квадратов, без возможности введения ограничений на значения параметров.

Возможность выбора метода оптимизации не предусмотрена.

Данный пакет считается устаревшим по сравнению, с least_squares.

Ссылка на документацию: https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.leastsq.html#scipy.optimize.leastsq.

from scipy.optimize import leastsq

# list of model

model_list = [

'linear', 'quadratic',

'qubic', 'power',

'exponential type 1', 'exponential type 2',

'logarithmic',

'hyperbolic']

# model reference

models_dict = {

'linear': linear_func,

'quadratic': quadratic_func,

'qubic': qubic_func,

'power': power_func,

'exponential type 1': exponential_type_1_func,

'exponential type 2': exponential_type_2_func,

'logarithmic': logarithmic_func,

'hyperbolic': hyperbolic_func}

# initial values

p0_dict = {

'linear': [0, 0],

'quadratic': [0, 0, 0],

'qubic': [0, 0, 0, 0],

'power': [0, 0],

'exponential type 1': [0, 0],

'exponential type 2': [1, 1],

'logarithmic': [0, 0],

'hyperbolic': [0, 0]}

# titles (formulas)

formulas_dict = {

'linear': 'y = b0 + b1*x',

'quadratic': 'y = b0 + b1*x + b2*x^2',

'qubic': 'y = b0 + b1*x + b2*x^2 + b3*x^3',

'power': 'y = b0*x^b1',

'exponential type 1': 'y = b0*exp(b1^x)',

'exponential type 2': 'y = b0*b1^x',

'logarithmic': 'y = b0 + b1*ln(x)',

'hyperbolic': 'y = b0+b1/x'}

# actual data

X_fact = X1

Y_fact = Y

# function for calculating residuals

residual_func = lambda p, x, y: y - func(x, *p)

# return all optional outputs

full_output = True

# variables to save the calculation results

calculation_results_df = pd.DataFrame(columns=['func', 'p0', 'popt', 'cov_x', 'SSE', 'MSE', 'pcov', 'perr', 'Y_calc', 'error_metrics'])

error_metrics_results_df = pd.DataFrame(columns=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE', 'R2'])

# calculations

for func_name in model_list:

print(f'{func_name.upper()} MODEL: {formulas_dict[func_name]}')

func = models_dict[func_name]

calculation_results_df.loc[func_name, 'func'] = func

p0 = p0_dict[func_name]

print(f'p0 = {p0}')

calculation_results_df.loc[func_name, 'p0'] = p0

if full_output:

(popt, cov_x, infodict, mesg, ier) = leastsq(residual_func, p0, args=(X_fact, Y_fact), full_output=full_output)

integer_flag = f'ier = {ier}, the solution was found' if ier<=4 else f'ier = {ier}, the solution was not found'

print(integer_flag, '\n', mesg)

calculation_results_df.loc[func_name, 'popt'] = popt

print(f'parameters = {popt}')

calculation_results_df.loc[func_name, 'cov_x'] = cov_x

print(f'cov_x = \n{cov_x}')

#SSE = (residual_func(popt, X_fact, Y_fact)**2).sum()

SSE = (infodict['fvec']**2).sum()

calculation_results_df.loc[func_name, 'SSE'] = SSE

print(f'SSE = {SSE}')

MSE = SSE / (len(Y_fact)-len(p0))

calculation_results_df.loc[func_name, 'MSE'] = MSE

print(f'MSE = {MSE}')

pcov = cov_x * MSE

calculation_results_df.loc[func_name, 'pcov'] = pcov

print(f'pcov =\n {pcov}')

perr = np.sqrt(np.diag(pcov))

calculation_results_df.loc[func_name, 'perr'] = perr

print(f'perr = {perr}\n')

else:

popt = leastsq(residual_func, p0, args=(X_fact, Y_fact), full_output=full_output)

calculation_results_df.loc[func_name, 'popt'] = popt

print(f'parameters = {popt}\n')

Y_calc = func(X_fact, *popt)

calculation_results_df.loc[func_name, 'Y_calc'] = Y_calc

(error_metrics_dict, error_metrics_df) = regression_error_metrics(Yfact=Y_fact, Ycalc=Y_calc, model_name=func_name)

calculation_results_df.loc[func_name, 'error_metrics'] = error_metrics_dict.values()

error_metrics_results_df = pd.concat([error_metrics_results_df, error_metrics_df]) LINEAR MODEL: y = b0 + b1*x

p0 = [0, 0]

ier = 3, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000 and the relative error between two consecutive iterates is at

most 0.000000

parameters = [ 1.1850e+01 -2.1760e-03]

cov_x =

[[ 8.7797e-02 -7.3041e-05]

[-7.3041e-05 7.6636e-08]]

SSE = 84.42039151684142

MSE = 1.5928375757894608

pcov =

[[ 1.3985e-01 -1.1634e-04]

[-1.1634e-04 1.2207e-07]]

perr = [3.7396e-01 3.4938e-04]

QUADRATIC MODEL: y = b0 + b1*x + b2*x^2

p0 = [0, 0, 0]

ier = 1, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000

parameters = [ 1.4343e+01 -7.0471e-03 1.8760e-06]

cov_x =

[[ 2.8731e-01 -4.6282e-04 1.5012e-07]

[-4.6282e-04 8.3812e-07 -2.9328e-10]

[ 1.5012e-07 -2.9328e-10 1.1295e-13]]

SSE = 53.26102533463595

MSE = 1.0242504872045375

pcov =

[[ 2.9428e-01 -4.7404e-04 1.5376e-07]

[-4.7404e-04 8.5844e-07 -3.0039e-10]

[ 1.5376e-07 -3.0039e-10 1.1569e-13]]

perr = [5.4247e-01 9.2652e-04 3.4013e-07]

QUBIC MODEL: y = b0 + b1*x + b2*x^2 + b3*x^3

p0 = [0, 0, 0, 0]

ier = 1, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000

parameters = [ 1.4838e+01 -8.8040e-03 3.5207e-06 -4.1264e-10]

cov_x =

[[ 5.7657e-01 -1.4894e-03 1.1111e-06 -2.4112e-10]

[-1.4894e-03 4.4815e-06 -3.7039e-09 8.5573e-13]

[ 1.1111e-06 -3.7039e-09 3.3058e-12 -8.0107e-16]

[-2.4112e-10 8.5573e-13 -8.0107e-16 2.0099e-19]]

SSE = 52.41383349470524

MSE = 1.0277222253863771

pcov =

[[ 5.9256e-01 -1.5307e-03 1.1419e-06 -2.4780e-10]

[-1.5307e-03 4.6057e-06 -3.8066e-09 8.7945e-13]

[ 1.1419e-06 -3.8066e-09 3.3974e-12 -8.2328e-16]

[-2.4780e-10 8.7945e-13 -8.2328e-16 2.0656e-19]]

perr = [7.6978e-01 2.1461e-03 1.8432e-06 4.5449e-10]

POWER MODEL: y = b0*x^b1

p0 = [0, 0]

ier = 1, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000

parameters = [33.4033 -0.1841]

cov_x =

[[ 1.2667e+01 -5.7225e-02]

[-5.7225e-02 2.6284e-04]]

SSE = 49.87968652194349

MSE = 0.9411261607913867

pcov =

[[ 1.1922e+01 -5.3856e-02]

[-5.3856e-02 2.4737e-04]]

perr = [3.4528 0.0157]

EXPONENTIAL TYPE 1 MODEL: y = b0*exp(b1^x)

p0 = [0, 0]

ier = 1, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000

parameters = [ 1.2624e+01 -2.7834e-04]

cov_x =

[[ 1.5566e-01 -1.1829e-05]

[-1.1829e-05 1.1127e-09]]

SSE = 75.19491109027253

MSE = 1.4187719073636327

pcov =

[[ 2.2085e-01 -1.6783e-05]

[-1.6783e-05 1.5787e-09]]

perr = [4.6994e-01 3.9733e-05]

EXPONENTIAL TYPE 2 MODEL: y = b0*b1^x

p0 = [1, 1]

ier = 1, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000

parameters = [12.6242 0.9997]

cov_x =

[[ 1.5566e-01 -1.1826e-05]

[-1.1826e-05 1.1121e-09]]

SSE = 75.19491108954423

MSE = 1.4187719073498912

pcov =

[[ 2.2085e-01 -1.6778e-05]

[-1.6778e-05 1.5778e-09]]

perr = [4.6994e-01 3.9722e-05]

LOGARITHMIC MODEL: y = b0 + b1*ln(x)

p0 = [0, 0]

ier = 3, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000 and the relative error between two consecutive iterates is at

most 0.000000

parameters = [23.9866 -2.1170]

cov_x =

[[ 2.1029 -0.3106]

[-0.3106 0.0463]]

SSE = 49.34256729321431

MSE = 0.9309918357210247

pcov =

[[ 1.9578 -0.2891]

[-0.2891 0.0431]]

perr = [1.3992 0.2075]

HYPERBOLIC MODEL: y = b0+b1/x

p0 = [0, 0]

ier = 1, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000

parameters = [ 9.2219 315.7336]

cov_x =

[[ 2.2732e-02 -2.5920e+00]

[-2.5920e+00 1.4765e+03]]

SSE = 78.69038671392151

MSE = 1.4847242776211607

pcov =

[[ 3.3751e-02 -3.8485e+00]

[-3.8485e+00 2.1922e+03]]

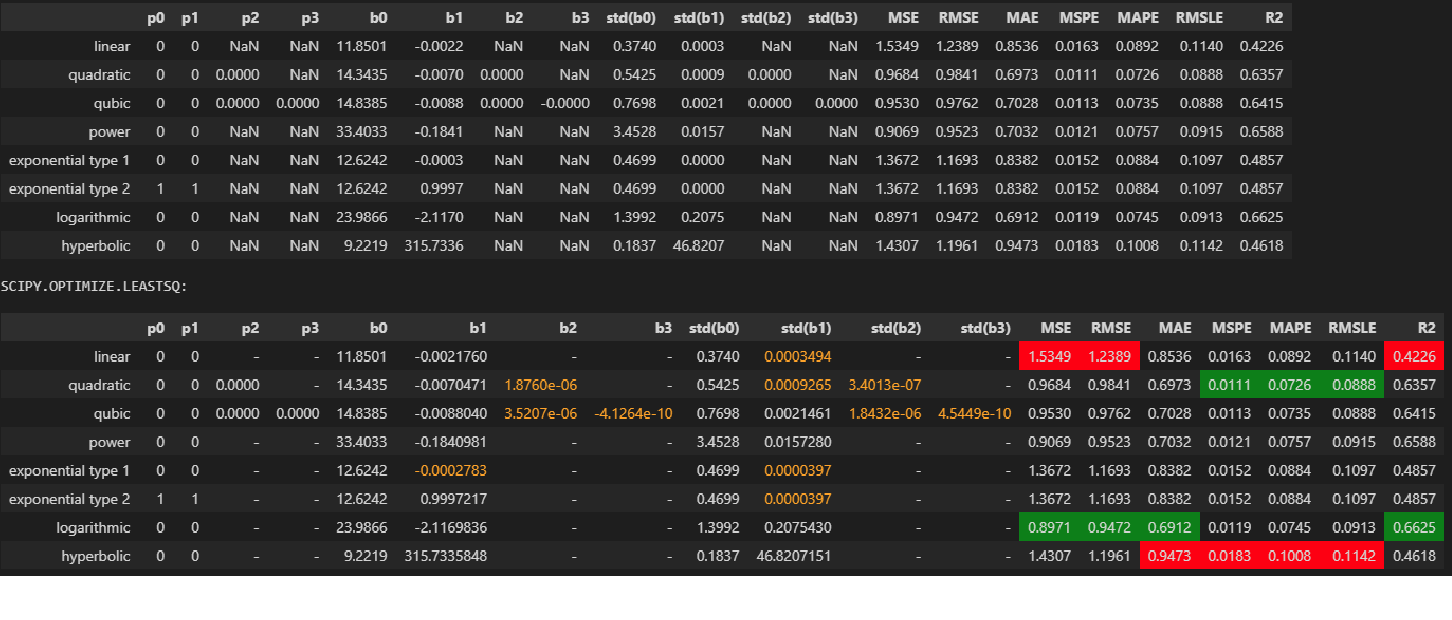

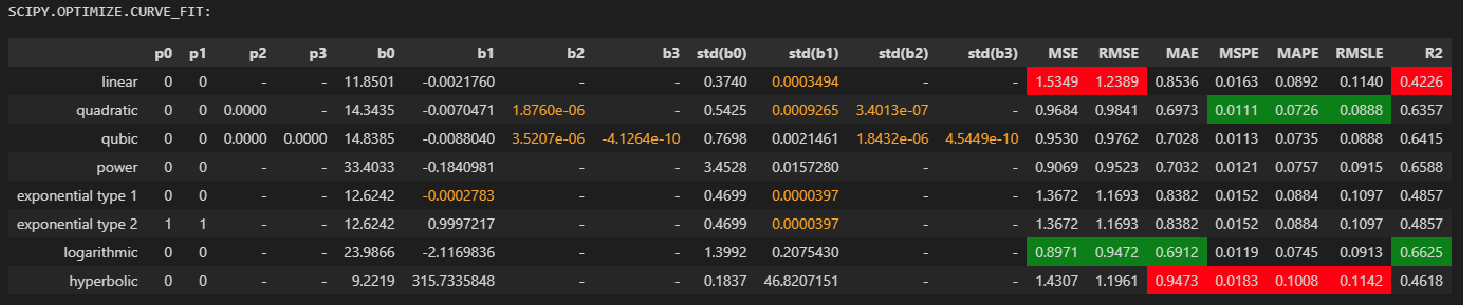

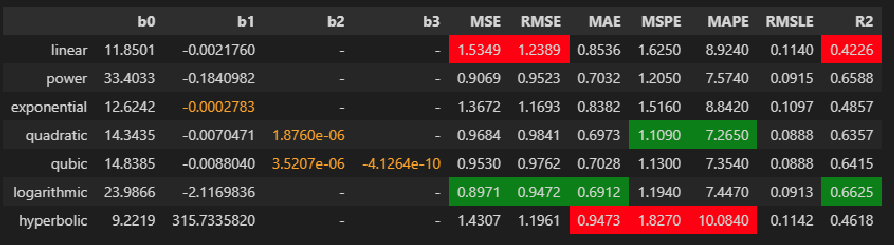

perr = [ 0.1837 46.8207]Теперь сформируем отдельный DataFrame, в котором соберем все результаты аппроксимации - параметры моделей (,

,

,

), метрики качества (MSE, RMSE, MAE, MSPE, MAPE, RMSLE,

) и начальные условия (

,

,

,

).

Для улучшения восприятия используем возможности Python по визуализации таблиц (https://pandas.pydata.org/pandas-docs/stable/user_guide/style.html):

заменим nan на "-";

значения параметров моделей, величина которых сравнима с установленным пределом точности отображения (DecPlace), выделим цветом (orange);

для параметра

установим повышенную точность отображения, а для параметров

,

установим экспоненциальный формат;

для метрик качества установим выделение цветом наилучшего (green) и наихудшего (red) результата.

При этом нужно обратить внимание на следующее - пользовательская функция regression_error_metrics возвращает результат как в виде DataFrame, так и в виде словаря (dict):

если мы используем данные в виде DataFrame, то необходимо откорректировать значения признаков MSPE и MAPE, так как пользовательская функция regression_error_metrics возвращает значения этих признаков в строковом формате (из-за знака '%') и при определении наилучшего и наихудшего результатов могут возникнуть ошибки (значение '10%' будет считаться лучшим результатом, чем '9%' из-за того, что первым символом является единица), поэтому следует удалить знак '%' и изменить тип данных на float;

если мы используем данные в виде словаря (dict), то подобная проблема не возникает.

result_df = pd.DataFrame(

list(calculation_results_df.loc[:,'p0'].values),

columns=['p0', 'p1', 'p2', 'p3'],

index=model_list)

result_df = result_df.join(pd.DataFrame(

list(calculation_results_df.loc[:,'popt'].values),

columns=['b0', 'b1', 'b2', 'b3'],

index=model_list))

result_df = result_df.join(pd.DataFrame(

list(calculation_results_df.loc[:,'perr'].values),

columns=['std(b0)', 'std(b1)', 'std(b2)', 'std(b3)'],

index=model_list))

result_df = result_df.join(pd.DataFrame(

list(calculation_results_df.loc[:,'error_metrics'].values),

columns=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE', 'R2'],

index=model_list))

display(result_df)

# settings for displaying the DataFrame: result_df

result_df_leastsq = result_df.copy()

'''for elem in ['MSPE', 'MAPE']:

result_df_leastsq[elem] = result_df_leastsq[elem].apply(lambda s: float(s[:-1]))'''

print('scipy.optimize.leastsq:'.upper())

display(result_df_leastsq

.style

.format(

precision=DecPlace, na_rep='-',

formatter={

'b1': '{:.' + str(DecPlace + 3) + 'f}',

'b2': '{:.' + str(DecPlace) + 'e}',

'b3': '{:.' + str(DecPlace) + 'e}',

'std(b1)': '{:.' + str(DecPlace + 3) + 'f}',

'std(b2)': '{:.' + str(DecPlace) + 'e}',

'std(b3)': '{:.' + str(DecPlace) + 'e}'})

.highlight_min(color='green', subset=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE'])

.highlight_max(color='red', subset=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE'])

.highlight_max(color='green', subset='R2')

.highlight_min(color='red', subset='R2')

.applymap(lambda x: 'color: orange;' if abs(x) <= 10**(-(DecPlace-1)) else None, subset=['b0', 'b1', 'b2', 'b3', 'std(b0)', 'std(b1)', 'std(b2)', 'std(b3)']))

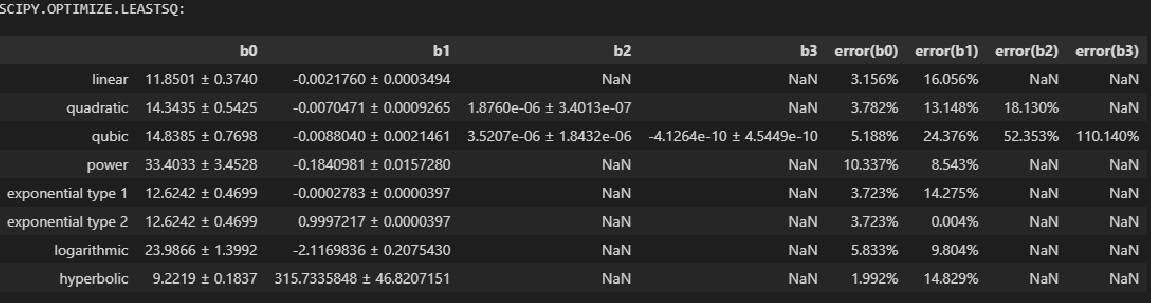

Сформируем DataFrame, содержащий ошибки и доверительные интервалы параметров моделей аппроксимации:

result_df_with_perr = pd.DataFrame()

parameter_name_list = ['b0', 'b1', 'b2', 'b3']

result_df_with_perr[parameter_name_list] = result_df[parameter_name_list]

parameter_format_dict = {

'b0': '{:.' + str(DecPlace) + 'f}',

'b1': '{:.' + str(DecPlace + 3) + 'f}',

'b2': '{:.' + str(DecPlace) + 'e}',

'b3': '{:.' + str(DecPlace) + 'e}',

'std(b1)': '{:.' + str(DecPlace + 3) + 'f}',

'std(b2)': '{:.' + str(DecPlace) + 'e}',

'std(b3)': '{:.' + str(DecPlace) + 'e}'}

for parameter in parameter_name_list:

for model in result_df.index:

if not result_df.isna().loc[model, parameter]:

result_df_with_perr.loc[model, parameter] = \

str(parameter_format_dict[parameter].format(result_df.loc[model, parameter])) + \

' ' + u"\u00B1" + ' ' + \

str(parameter_format_dict[parameter].format(result_df.loc[model, 'std('+parameter+')']))

relative_errors = abs(result_df.loc[model, 'std('+parameter+')'] / result_df.loc[model, parameter])

result_df_with_perr.loc[model, 'error('+parameter+')'] = '{:.3%}'.format(relative_errors)

result_df_with_perr_leastsq = result_df_with_perr.copy()

print('scipy.optimize.leastsq:'.upper())

display(result_df_with_perr_leastsq)

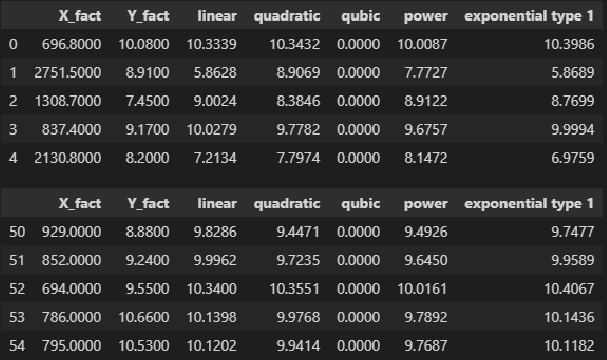

XY_calc_df = pd.DataFrame({

'X_fact': X_fact,

'Y_fact': Y_fact})

for i, model in enumerate(model_list):

XY_calc_df[model] = calculation_results_df.loc[model, 'Y_calc']

display(XY_calc_df.head(), XY_calc_df.tail())

Построим графики аппроксимации (по аналогии с Excel):

# setting colors for graphs

color_dict = {

'linear': 'blue',

'quadratic': 'darkblue',

'qubic': 'slateblue',

'power': 'magenta',

'exponential type 1': 'cyan',

'exponential type 2': 'black',

'logarithmic': 'orange',

'inverse logarithmic': 'gold',

'hyperbolic': 'grey',

'hyperbolic type 2': 'darkgrey',

'hyperbolic type 3': 'lightgrey',

'modified exponential type 1': 'darkcyan',

'modified exponential type 2': 'black',

'logistic type 1': 'green',

'logistic type 2': 'darkgreen',

'Gompertz': 'brown'

}

linewidth_dict = {

'linear': 2,

'quadratic': 2,

'qubic': 2,

'power': 2,

'exponential type 1': 5,

'exponential type 2': 1,

'logarithmic': 2,

'inverse logarithmic': 2,

'hyperbolic': 2,

'hyperbolic type 2': 2,

'hyperbolic type 3': 2,

'modified exponential type 1': 2,

'modified exponential type 2': 2,

'logistic type 1': 2,

'logistic type 2': 2,

'Gompertz': 2

}

# changing the Matplotlib settings

plt.rcParams['axes.titlesize'] = 14

plt.rcParams['legend.fontsize'] = 12

plt.rcParams['xtick.labelsize'] = 12

plt.rcParams['ytick.labelsize'] = 12

# bounds of values of variables (when plotting)

Xmin = X1_min_graph

Xmax = X1_max_graph

Ymin = Y_min_graph

Ymax = Y_max_graph

# the value of the independent variable (when plotting)

nx = 100

hx = (Xmax - Xmin)/(nx - 1)

X_calc_graph = np.linspace(Xmin, Xmax, nx)

# plotting

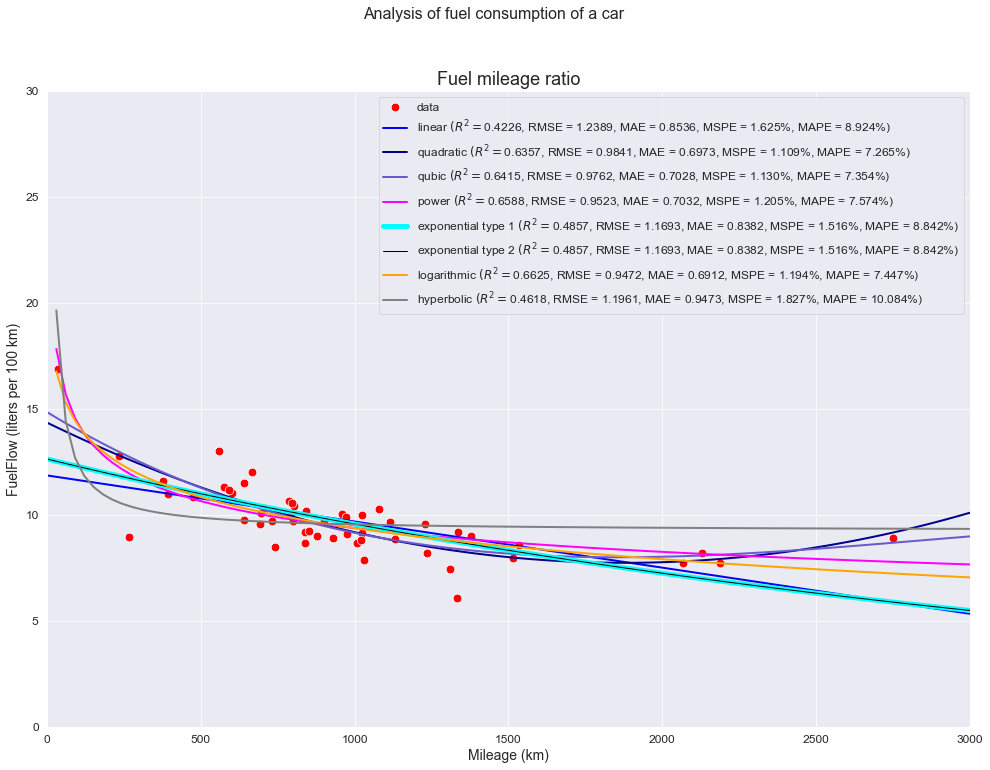

fig, axes = plt.subplots(figsize=(420/INCH, 297/INCH))

title_figure = Title_String + '\n' + Task_Theme + '\n'

fig.suptitle(title_figure, fontsize = 16)

title_axes = 'Fuel mileage ratio'

axes.set_title(title_axes, fontsize = 18)

# actual data

sns.scatterplot(

x=X_fact, y=Y_fact,

label='data',

s=75,

color='red',

ax=axes)

# models

for func_name in model_list:

R2 = round(result_df.loc[func_name,'R2'], DecPlace)

RMSE = round(result_df.loc[func_name,'RMSE'], DecPlace)

MAE = round(result_df.loc[func_name,'MAE'], DecPlace)

MSPE = "{:.3%}".format(result_df.loc[func_name,'MSPE'])

MAPE = "{:.3%}".format(result_df.loc[func_name,'MAPE'])

label = func_name + ' '+ r'$(R^2 = $' + f'{R2}' + ', ' + f'RMSE = {RMSE}' + ', ' + f'MAE = {MAE}' + ', ' + f'MSPE = {MSPE}' + ', ' + f'MAPE = {MAPE})'

func = calculation_results_df.loc[func_name, 'func']

popt = calculation_results_df.loc[func_name, 'popt']

sns.lineplot(

x=X_calc_graph, y=func(X_calc_graph, *popt),

color=color_dict[func_name],

linewidth=linewidth_dict[func_name],

legend=True,

label=label,

ax=axes)

axes.set_xlim(Xmin, Xmax)

axes.set_ylim(Ymin, Ymax)

axes.set_xlabel(Variable_Name_X1, fontsize = 14)

axes.set_ylabel(Variable_Name_Y, fontsize = 14)

axes.legend(prop={'size': 12})

plt.show()

Аппроксимация с использованием scipy.optimize.least_squares

Особенности использования функции:

Реализация нелинейного метода наименьших квадратов, с возможностью введения ограничений на значения параметров.

Имеется возможность выбора алгоритма оптимизации:

trf (Trust Region Reflective) - установлен по умолчанию, надежный метод, особенно подходящий для больших задач с ограничениями;

dogbox - для небольших задач с ограничениями;

lm (Levenberg-Marquardt algorithm) - для небольших задач без ограничений.

Ссылка на документацию: https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.least_squares.html#scipy.optimize.least_squares

from scipy.optimize import least_squares

# algorithm to perform minimization

methods_dict = {

'linear': 'lm',

'quadratic': 'lm',

'qubic': 'lm',

'power': 'lm',

'exponential type 1': 'lm',

'exponential type 2': 'lm',

'logarithmic': 'lm',

'hyperbolic': 'lm'}

# actual data

X_fact = X1

Y_fact = Y

# function for calculating residuals

residual_func = lambda p, x, y: y - func(x, *p)

# return all optional outputs

full_output = True

# variables to save the calculation results

calculation_results_df = pd.DataFrame(columns=['func', 'p0', 'popt', 'jac', 'hess', 'SSE', 'MSE', 'pcov', 'perr', 'Y_calc', 'error_metrics'])

error_metrics_results_df = pd.DataFrame(columns=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE', 'R2'])

# calculations

for func_name in model_list:

print(f'{func_name.upper()} MODEL: {formulas_dict[func_name]}')

func = models_dict[func_name]

calculation_results_df.loc[func_name, 'func'] = func

p0 = p0_dict[func_name]

print(f'p0 = {p0}')

calculation_results_df.loc[func_name, 'p0'] = p0

res = sci.optimize.least_squares(residual_func, p0, args=(X_fact, Y_fact), method=methods_dict[func_name])

(popt, jac) = (res.x, res.jac)

calculation_results_df.loc[func_name, 'popt'] = popt

calculation_results_df.loc[func_name, 'jac'] = jac

print(f'parameters = {popt}')

#print(f'jac =\n {jac}')

hess = np.linalg.inv(np.dot(jac.T, jac))

calculation_results_df.loc[func_name, 'hess'] = hess

print(f'hess =\n {hess}')

SSE = (residual_func(popt, X_fact, Y_fact)**2).sum()

calculation_results_df.loc[func_name, 'SSE'] = SSE

print(f'SSE = {SSE}')

MSE = SSE / (len(Y_fact)-len(p0))

calculation_results_df.loc[func_name, 'MSE'] = MSE

print(f'MSE = {MSE}')

pcov = hess * MSE

calculation_results_df.loc[func_name, 'pcov'] = pcov

print(f'pcov =\n {pcov}')

perr = np.sqrt(np.diag(pcov))

calculation_results_df.loc[func_name, 'perr'] = perr

print(f'perr = {perr}\n')

Y_calc = func(X_fact, *popt)

calculation_results_df.loc[func_name, 'Y_calc'] = Y_calc

(error_metrics_dict, error_metrics_df) = regression_error_metrics(Yfact=Y_fact, Ycalc=Y_calc, model_name=func_name)

calculation_results_df.loc[func_name, 'error_metrics'] = error_metrics_dict.values()

error_metrics_results_df = pd.concat([error_metrics_results_df, error_metrics_df])LINEAR MODEL: y = b0 + b1*x

p0 = [0, 0]

parameters = [ 1.1850e+01 -2.1760e-03]

hess =

[[ 8.7797e-02 -7.3041e-05]

[-7.3041e-05 7.6636e-08]]

SSE = 84.42039151684142

MSE = 1.5928375757894608

pcov =

[[ 1.3985e-01 -1.1634e-04]

[-1.1634e-04 1.2207e-07]]

perr = [3.7396e-01 3.4938e-04]

QUADRATIC MODEL: y = b0 + b1*x + b2*x^2

p0 = [0, 0, 0]

parameters = [ 1.4343e+01 -7.0471e-03 1.8760e-06]

hess =

[[ 2.8731e-01 -4.6282e-04 1.5012e-07]

[-4.6282e-04 8.3812e-07 -2.9328e-10]

[ 1.5012e-07 -2.9328e-10 1.1295e-13]]

SSE = 53.26102533463595

MSE = 1.0242504872045375

pcov =

[[ 2.9428e-01 -4.7404e-04 1.5376e-07]

[-4.7404e-04 8.5844e-07 -3.0039e-10]

[ 1.5376e-07 -3.0039e-10 1.1569e-13]]

perr = [5.4247e-01 9.2652e-04 3.4013e-07]

QUBIC MODEL: y = b0 + b1*x + b2*x^2 + b3*x^3

p0 = [0, 0, 0, 0]

parameters = [ 1.4838e+01 -8.8040e-03 3.5207e-06 -4.1264e-10]

hess =

[[ 5.7657e-01 -1.4894e-03 1.1111e-06 -2.4112e-10]

[-1.4894e-03 4.4815e-06 -3.7039e-09 8.5573e-13]

[ 1.1111e-06 -3.7039e-09 3.3058e-12 -8.0107e-16]

[-2.4112e-10 8.5573e-13 -8.0107e-16 2.0099e-19]]

SSE = 52.413833494705216

MSE = 1.0277222253863767

pcov =

[[ 5.9256e-01 -1.5307e-03 1.1419e-06 -2.4780e-10]

[-1.5307e-03 4.6057e-06 -3.8066e-09 8.7945e-13]

[ 1.1419e-06 -3.8066e-09 3.3974e-12 -8.2328e-16]

[-2.4780e-10 8.7945e-13 -8.2328e-16 2.0656e-19]]

perr = [7.6978e-01 2.1461e-03 1.8432e-06 4.5449e-10]

POWER MODEL: y = b0*x^b1

p0 = [0, 0]

parameters = [33.4033 -0.1841]

hess =

[[ 1.2667e+01 -5.7226e-02]

[-5.7226e-02 2.6284e-04]]

SSE = 49.87968652202211

MSE = 0.94112616079287

pcov =

[[ 1.1922e+01 -5.3857e-02]

[-5.3857e-02 2.4737e-04]]

perr = [3.4528 0.0157]

EXPONENTIAL TYPE 1 MODEL: y = b0*exp(b1^x)

p0 = [0, 0]

parameters = [ 1.2624e+01 -2.7834e-04]

hess =

[[ 1.5566e-01 -1.1829e-05]

[-1.1829e-05 1.1127e-09]]

SSE = 75.19491109027253

MSE = 1.4187719073636327

pcov =

[[ 2.2085e-01 -1.6782e-05]

[-1.6782e-05 1.5787e-09]]

perr = [4.6994e-01 3.9732e-05]

EXPONENTIAL TYPE 2 MODEL: y = b0*b1^x

p0 = [1, 1]

parameters = [12.6242 0.9997]

hess =

[[ 1.5566e-01 -1.1825e-05]

[-1.1825e-05 1.1121e-09]]

SSE = 75.19491108936178

MSE = 1.4187719073464486

pcov =

[[ 2.2085e-01 -1.6778e-05]

[-1.6778e-05 1.5778e-09]]

perr = [4.6994e-01 3.9721e-05]

LOGARITHMIC MODEL: y = b0 + b1*ln(x)

p0 = [0, 0]

parameters = [23.9866 -2.1170]

hess =

[[ 2.1029 -0.3106]

[-0.3106 0.0463]]

SSE = 49.342567293214316

MSE = 0.9309918357210248

pcov =

[[ 1.9578 -0.2891]

[-0.2891 0.0431]]

perr = [1.3992 0.2075]

HYPERBOLIC MODEL: y = b0+b1/x

p0 = [0, 0]

parameters = [ 9.2219 315.7336]

hess =

[[ 2.2732e-02 -2.5920e+00]

[-2.5920e+00 1.4765e+03]]

SSE = 78.69038671392154

MSE = 1.484724277621161

pcov =

[[ 3.3751e-02 -3.8485e+00]

[-3.8485e+00 2.1922e+03]]

perr = [ 0.1837 46.8207]По аналогии с предыдущим примером, сформируем отдельный DataFrame, в котором соберем все результаты аппроксимации, и сравним с результатами из предыдущего примера:

result_df = pd.DataFrame(

list(calculation_results_df.loc[:,'p0'].values),

columns=['p0', 'p1', 'p2', 'p3'],

index=model_list)

result_df = result_df.join(pd.DataFrame(

list(calculation_results_df.loc[:,'popt'].values),

columns=['b0', 'b1', 'b2', 'b3'],

index=model_list))

result_df = result_df.join(pd.DataFrame(

list(calculation_results_df.loc[:,'perr'].values),

columns=['std(b0)', 'std(b1)', 'std(b2)', 'std(b3)'],

index=model_list))

result_df = result_df.join(pd.DataFrame(

list(calculation_results_df.loc[:,'error_metrics'].values),

columns=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE', 'R2'],

index=model_list))

#display(result_df)

# settings for displaying the DataFrame: result_df

result_df_least_squares = result_df.copy()

'''for elem in ['MSPE', 'MAPE']:

result_df_leastsq[elem] = result_df_leastsq[elem].apply(lambda s: float(s[:-1]))'''

print('scipy.optimize.least_squares:'.upper())

display(result_df_least_squares

.style

.format(

precision=DecPlace, na_rep='-',

formatter={

'b1': '{:.' + str(DecPlace + 3) + 'f}',

'b2': '{:.' + str(DecPlace) + 'e}',

'b3': '{:.' + str(DecPlace) + 'e}',

'std(b1)': '{:.' + str(DecPlace + 3) + 'f}',

'std(b2)': '{:.' + str(DecPlace) + 'e}',

'std(b3)': '{:.' + str(DecPlace) + 'e}'})

.highlight_min(color='green', subset=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE'])

.highlight_max(color='red', subset=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE'])

.highlight_max(color='green', subset='R2')

.highlight_min(color='red', subset='R2')

.applymap(lambda x: 'color: orange;' if abs(x) <= 10**(-(DecPlace-1)) else None, subset=['b0', 'b1', 'b2', 'b3', 'std(b0)', 'std(b1)', 'std(b2)', 'std(b3)']))

print('scipy.optimize.leastsq:'.upper())

display(result_df_leastsq

.style

.format(

precision=DecPlace, na_rep='-',

formatter={

'b1': '{:.' + str(DecPlace + 3) + 'f}',

'b2': '{:.' + str(DecPlace) + 'e}',

'b3': '{:.' + str(DecPlace) + 'e}',

'std(b1)': '{:.' + str(DecPlace + 3) + 'f}',

'std(b2)': '{:.' + str(DecPlace) + 'e}',

'std(b3)': '{:.' + str(DecPlace) + 'e}'})

.highlight_min(color='green', subset=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE'])

.highlight_max(color='red', subset=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE'])

.highlight_max(color='green', subset='R2')

.highlight_min(color='red', subset='R2')

.applymap(lambda x: 'color: orange;' if abs(x) <= 10**(-(DecPlace-1)) else None, subset=['b0', 'b1', 'b2', 'b3', 'std(b0)', 'std(b1)', 'std(b2)', 'std(b3)']))

Сформируем DataFrame, содержащий ошибки и доверительные интервалы параметров моделей аппроксимации, и сравним с результатами из предыдущего примера:

result_df_with_perr = pd.DataFrame()

parameter_name_list = ['b0', 'b1', 'b2', 'b3']

result_df_with_perr[parameter_name_list] = result_df[parameter_name_list]

parameter_format_dict = {

'b0': '{:.' + str(DecPlace) + 'f}',

'b1': '{:.' + str(DecPlace + 3) + 'f}',

'b2': '{:.' + str(DecPlace) + 'e}',

'b3': '{:.' + str(DecPlace) + 'e}',

'std(b1)': '{:.' + str(DecPlace + 3) + 'f}',

'std(b2)': '{:.' + str(DecPlace) + 'e}',

'std(b3)': '{:.' + str(DecPlace) + 'e}'}

for parameter in parameter_name_list:

for model in result_df.index:

if not result_df.isna().loc[model, parameter]:

result_df_with_perr.loc[model, parameter] = \

str(parameter_format_dict[parameter].format(result_df.loc[model, parameter])) + \

' ' + u"\u00B1" + ' ' + \

str(parameter_format_dict[parameter].format(result_df.loc[model, 'std('+parameter+')']))

relative_errors = abs(result_df.loc[model, 'std('+parameter+')'] / result_df.loc[model, parameter])

result_df_with_perr.loc[model, 'error('+parameter+')'] = '{:.3%}'.format(relative_errors)

result_df_with_perr_least_squares = result_df_with_perr.copy()

print('scipy.optimize.least_squares:'.upper())

display(result_df_with_perr_least_squares)

print('scipy.optimize.leastsq:'.upper())

display(result_df_with_perr_leastsq)

Аппроксимация с использованием scipy.optimize.curve_fit

Особенности использования функции:

Реализация нелинейного метода наименьших квадратов, с возможностью введения ограничений на значения параметров.

Имеется возможность выбора алгоритма оптимизации (trf, dogbox, lm), по аналогии с scipy.optimize.least_squares).

Ссылка на документацию: https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.curve_fit.html

from scipy.optimize import curve_fit

# algorithm to perform minimization

methods_dict = {

'linear': 'lm',

'quadratic': 'lm',

'qubic': 'lm',

'power': 'lm',

'exponential type 1': 'lm',

'exponential type 2': 'lm',

'logarithmic': 'lm',

'hyperbolic': 'lm'}

# actual data

X_fact = X1

Y_fact = Y

# return all optional outputs

full_output = True

# variables to save the calculation results

calculation_results_df = pd.DataFrame(columns=['func', 'p0', 'popt', 'pcov', 'perr', 'Y_calc', 'error_metrics'])

error_metrics_results_df = pd.DataFrame(columns=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE', 'R2'])

# calculations

for func_name in model_list:

print(f'{func_name.upper()} MODEL: {formulas_dict[func_name]}')

func = models_dict[func_name]

calculation_results_df.loc[func_name, 'func'] = func

p0 = p0_dict[func_name]

print(f'p0 = {p0}')

calculation_results_df.loc[func_name, 'p0'] = p0

if full_output:

(popt, pcov, infodict, mesg, ier) = curve_fit(func, X_fact, Y_fact, p0=p0, method=methods_dict[func_name], full_output=full_output)

integer_flag = f'ier = {ier}, the solution was found' if ier<=4 else f'ier = {ier}, the solution was not found'

print(integer_flag, '\n', mesg)

calculation_results_df.loc[func_name, 'popt'] = popt

print(f'parameters = {popt}')

calculation_results_df.loc[func_name, 'pcov'] = pcov

print(f'pcov =\n {pcov}')

perr = np.sqrt(np.diag(pcov))

calculation_results_df.loc[func_name, 'perr'] = perr

print(f'perr = {perr}\n')

else:

(popt, pcov) = curve_fit(func, X_fact, Y_fact, p0=p0, method=methods_dict[func_name], full_output=full_output)

calculation_results_df.loc[func_name, 'popt'] = popt

print(f'parameters = {popt}')

calculation_results_df.loc[func_name, 'pcov'] = pcov

print(f'pcov =\n {pcov}')

perr = np.sqrt(np.diag(pcov))

calculation_results_df.loc[func_name, 'perr'] = perr

print(f'perr = {perr}\n')

Y_calc = func(X_fact, *popt)

calculation_results_df.loc[func_name, 'Y_calc'] = Y_calc

(error_metrics_dict, error_metrics_df) = regression_error_metrics(Yfact=Y_fact, Ycalc=Y_calc, model_name=func_name)

calculation_results_df.loc[func_name, 'error_metrics'] = error_metrics_dict.values()

error_metrics_results_df = pd.concat([error_metrics_results_df, error_metrics_df]) LINEAR MODEL: y = b0 + b1*x

p0 = [0, 0]

ier = 3, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000 and the relative error between two consecutive iterates is at

most 0.000000

parameters = [ 1.1850e+01 -2.1760e-03]

pcov =

[[ 1.3985e-01 -1.1634e-04]

[-1.1634e-04 1.2207e-07]]

perr = [3.7396e-01 3.4938e-04]

QUADRATIC MODEL: y = b0 + b1*x + b2*x^2

p0 = [0, 0, 0]

ier = 1, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000

parameters = [ 1.4343e+01 -7.0471e-03 1.8760e-06]

pcov =

[[ 2.9428e-01 -4.7404e-04 1.5376e-07]

[-4.7404e-04 8.5844e-07 -3.0039e-10]

[ 1.5376e-07 -3.0039e-10 1.1569e-13]]

perr = [5.4247e-01 9.2652e-04 3.4013e-07]

QUBIC MODEL: y = b0 + b1*x + b2*x^2 + b3*x^3

p0 = [0, 0, 0, 0]

ier = 1, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000

parameters = [ 1.4838e+01 -8.8040e-03 3.5207e-06 -4.1264e-10]

pcov =

[[ 5.9256e-01 -1.5307e-03 1.1419e-06 -2.4780e-10]

[-1.5307e-03 4.6057e-06 -3.8066e-09 8.7945e-13]

[ 1.1419e-06 -3.8066e-09 3.3974e-12 -8.2328e-16]

[-2.4780e-10 8.7945e-13 -8.2328e-16 2.0656e-19]]

perr = [7.6978e-01 2.1461e-03 1.8432e-06 4.5449e-10]

POWER MODEL: y = b0*x^b1

p0 = [0, 0]

ier = 1, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000

parameters = [33.4033 -0.1841]

pcov =

[[ 1.1922e+01 -5.3856e-02]

[-5.3856e-02 2.4737e-04]]

perr = [3.4528 0.0157]

EXPONENTIAL TYPE 1 MODEL: y = b0*exp(b1^x)

p0 = [0, 0]

ier = 1, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000

parameters = [ 1.2624e+01 -2.7834e-04]

pcov =

[[ 2.2085e-01 -1.6783e-05]

[-1.6783e-05 1.5787e-09]]

perr = [4.6994e-01 3.9733e-05]

EXPONENTIAL TYPE 2 MODEL: y = b0*b1^x

p0 = [1, 1]

ier = 1, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000

parameters = [12.6242 0.9997]

pcov =

[[ 2.2085e-01 -1.6778e-05]

[-1.6778e-05 1.5778e-09]]

perr = [4.6994e-01 3.9722e-05]

LOGARITHMIC MODEL: y = b0 + b1*ln(x)

p0 = [0, 0]

ier = 3, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000 and the relative error between two consecutive iterates is at

most 0.000000

parameters = [23.9866 -2.1170]

pcov =

[[ 1.9578 -0.2891]

[-0.2891 0.0431]]

perr = [1.3992 0.2075]

HYPERBOLIC MODEL: y = b0+b1/x

p0 = [0, 0]

ier = 1, the solution was found

Both actual and predicted relative reductions in the sum of squares

are at most 0.000000

parameters = [ 9.2219 315.7336]

pcov =

[[ 3.3751e-02 -3.8485e+00]

[-3.8485e+00 2.1922e+03]]

perr = [ 0.1837 46.8207]По аналогии с предыдущим примером, сформируем отдельный DataFrame, в котором соберем все результаты аппроксимации, и сравним с результатами из предыдущих примеров:

result_df = pd.DataFrame(

list(calculation_results_df.loc[:,'p0'].values),

columns=['p0', 'p1', 'p2', 'p3'],

index=model_list)

result_df = result_df.join(pd.DataFrame(

list(calculation_results_df.loc[:,'popt'].values),

columns=['b0', 'b1', 'b2', 'b3'],

index=model_list))

result_df = result_df.join(pd.DataFrame(

list(calculation_results_df.loc[:,'perr'].values),

columns=['std(b0)', 'std(b1)', 'std(b2)', 'std(b3)'],

index=model_list))

result_df = result_df.join(pd.DataFrame(

list(calculation_results_df.loc[:,'error_metrics'].values),

columns=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE', 'R2'],

index=model_list))

#display(result_df)

# settings for displaying the DataFrame: result_df

result_df_curve_fit = result_df.copy()

'''for elem in ['MSPE', 'MAPE']:

result_df_leastsq[elem] = result_df_leastsq[elem].apply(lambda s: float(s[:-1]))'''

print('scipy.optimize.curve_fit:'.upper())

display(result_df_curve_fit

.style

.format(

precision=DecPlace, na_rep='-',

formatter={

'b1': '{:.' + str(DecPlace + 3) + 'f}',

'b2': '{:.' + str(DecPlace) + 'e}',

'b3': '{:.' + str(DecPlace) + 'e}',

'std(b1)': '{:.' + str(DecPlace + 3) + 'f}',

'std(b2)': '{:.' + str(DecPlace) + 'e}',

'std(b3)': '{:.' + str(DecPlace) + 'e}'})

.highlight_min(color='green', subset=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE'])

.highlight_max(color='red', subset=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE'])

.highlight_max(color='green', subset='R2')

.highlight_min(color='red', subset='R2')

.applymap(lambda x: 'color: orange;' if abs(x) <= 10**(-(DecPlace-1)) else None, subset=['b0', 'b1', 'b2', 'b3', 'std(b0)', 'std(b1)', 'std(b2)', 'std(b3)']))

print('scipy.optimize.least_squares:'.upper())

display(result_df_least_squares

.style

.format(

precision=DecPlace, na_rep='-',

formatter={

'b1': '{:.' + str(DecPlace + 3) + 'f}',

'b2': '{:.' + str(DecPlace) + 'e}',

'b3': '{:.' + str(DecPlace) + 'e}',

'std(b1)': '{:.' + str(DecPlace + 3) + 'f}',

'std(b2)': '{:.' + str(DecPlace) + 'e}',

'std(b3)': '{:.' + str(DecPlace) + 'e}'})

.highlight_min(color='green', subset=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE'])

.highlight_max(color='red', subset=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE'])

.highlight_max(color='green', subset='R2')

.highlight_min(color='red', subset='R2')

.applymap(lambda x: 'color: orange;' if abs(x) <= 10**(-(DecPlace-1)) else None, subset=['b0', 'b1', 'b2', 'b3', 'std(b0)', 'std(b1)', 'std(b2)', 'std(b3)']))

print('scipy.optimize.least_squares:'.upper())

display(result_df_leastsq

.style

.format(

precision=DecPlace, na_rep='-',

formatter={

'b1': '{:.' + str(DecPlace + 3) + 'f}',

'b2': '{:.' + str(DecPlace) + 'e}',

'b3': '{:.' + str(DecPlace) + 'e}',

'std(b1)': '{:.' + str(DecPlace + 3) + 'f}',

'std(b2)': '{:.' + str(DecPlace) + 'e}',

'std(b3)': '{:.' + str(DecPlace) + 'e}'})

.highlight_min(color='green', subset=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE'])

.highlight_max(color='red', subset=['MSE', 'RMSE', 'MAE', 'MSPE', 'MAPE', 'RMSLE'])

.highlight_max(color='green', subset='R2')

.highlight_min(color='red', subset='R2')

.applymap(lambda x: 'color: orange;' if abs(x) <= 10**(-(DecPlace-1)) else None, subset=['b0', 'b1', 'b2', 'b3', 'std(b0)', 'std(b1)', 'std(b2)', 'std(b3)']))

По аналогии с предыдущим примером, сформируем отдельный DataFrame, содержащий ошибки и доверительные интервалы параметров моделей аппроксимации, и сравним с результатами из предыдущих примеров:

result_df_with_perr = pd.DataFrame()

parameter_name_list = ['b0', 'b1', 'b2', 'b3']

result_df_with_perr[parameter_name_list] = result_df[parameter_name_list]

parameter_format_dict = {

'b0': '{:.' + str(DecPlace) + 'f}',

'b1': '{:.' + str(DecPlace + 3) + 'f}',

'b2': '{:.' + str(DecPlace) + 'e}',

'b3': '{:.' + str(DecPlace) + 'e}',

'std(b1)': '{:.' + str(DecPlace + 3) + 'f}',

'std(b2)': '{:.' + str(DecPlace) + 'e}',

'std(b3)': '{:.' + str(DecPlace) + 'e}'}

for parameter in parameter_name_list:

for model in result_df.index:

if not result_df.isna().loc[model, parameter]:

result_df_with_perr.loc[model, parameter] = \

str(parameter_format_dict[parameter].format(result_df.loc[model, parameter])) + \

' ' + u"\u00B1" + ' ' + \

str(parameter_format_dict[parameter].format(result_df.loc[model, 'std('+parameter+')']))

relative_errors = abs(result_df.loc[model, 'std('+parameter+')'] / result_df.loc[model, parameter])

result_df_with_perr.loc[model, 'error('+parameter+')'] = '{:.3%}'.format(relative_errors)

result_df_with_perr_curve_fit = result_df_with_perr.copy()

print('scipy.optimize.curve_fit:'.upper())

display(result_df_with_perr_curve_fit)

print('scipy.optimize.least_squares:'.upper())

display(result_df_with_perr_least_squares)

print('scipy.optimize.leastsq:'.upper())

display(result_df_with_perr_leastsq)

Аппроксимация с использованием scipy.optimize.minimize

Особенности использования функции:

Минимизация значений скалярной функции одной или нескольких переменных; при использовании в качестве функции суммы квадратов получаем реализацию нелинейного метода наименьших квадратов.

Имеется возможность выбора широкого набора алгоритмов оптимизации (Nelder-Mead, Powell, CG, BFGS, Newton-CG, L-BFGS-B, TNC, COBYLA, SLSQP, trust-constr, dogleg, trust-ncg, trust-exact, trust-krylov, custom), получить информацию можно с помощью функции scipy.optimize.show_options (https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.show_options.html#scipy.optimize.show_options), а также есть возможность добавить пользовательский алгоритм оптимизации.

Ссылка на документацию: https://docs.scipy.org/doc/scipy/reference/generated/scipy.optimize.minimize.html#scipy.optimize.minimize

Работа с данной функцией принципиально не отличается от разобранных выше, поэтому в целях экономии места в данном обзоре подробности приводить не буду; все рабочие файлы с примерами расчетов доступны в моем репозитории на GitHub (https://github.com/AANazarov/Statistical-methods).

Аппроксимация с использованием библиотеки lmfit

Библиотека lmfit - это универсальный инструмент для решения задач нелинейной оптимизации, в том числе и для аппроксимации зависимостей, представляет собой дальнейшее развитие scipy.optimize.

Особенности использования библиотеки lmfit для аппроксимации:

В качестве переменных вместо обычных чисел типа float используются объекты класса Parameter, которые обладают гораздо более обширным функционалом (https://lmfit.github.io/lmfit-py/parameters.html#lmfit.parameter.Parameter):

для них возможно задавать границы допустимых значений и ограничения в виде алгебраических выражений;

возможно фиксировать значения в процессе подгонки;

после подгонки возможно получить такие атрибуты, как стандартная ошибка и коэффициенты корреляции с другими параметрами модели;

возможно указывать размер шага для точек сетки в методе полного перебора и т.д.

Имеется возможность выбора широкого набора алгоритмов оптимизации (leastsq - default, least_squares, differential_evolution, brute, basinhopping, ampgo, nelder, lbfgsb, powell, cg, newton, cobyla, bfgs, tnc, trust-ncg, trust-exact, trust-krylov, trust-constr, dogleg, slsqp, emcee, shgo, dual_annealing) (https://lmfit.github.io/lmfit-py/fitting.html#choosing-different-fitting-methods).

Имеется возможность выбора различных целевых функций минимизации: по умолчанию - сумма квадратов остатков

, но в случае, например, наличия выбросов может применяться negentropy - отрицательная энтропия, использующая нормальное распределение

(где

),

neglogcauchy - отрицательная логарифмическая вероятность,использующая распределения Коши

,

либо callable - функция, определенная пользователем; подробнее см. https://lmfit.github.io/lmfit-py/fitting.html#using-the-minimizer-class.

Улучшена оценка доверительных интервалов. Хотя scipy.optimize.leastsq автоматически вычисляет неопределенности и корреляции из ковариационной матрицы, точность этих оценок иногда вызывает сомнения. Чтобы помочь решить эту проблему, lmfit имеет функции явного исследования пространства параметров и определения уровней доверительной вероятности даже в самых сложных случаях.

Возможность работы с классом Model (https://lmfit.github.io/lmfit-py/model.html#lmfit.model.Model).

Имеется набор встроенных моделей (https://lmfit.github.io/lmfit-py/builtin_models.html#builtin-models-chapter).

Для полного контроля над процессом оптимизации имеется возможность работы с объектом класса Minimizer (https://lmfit.github.io/lmfit-py/fitting.html#using-the-minimizer-class).

Имеются встроенные инструменты вывода отчетов и построения графиков.

Ссылка на документацию к библиотеке: https://lmfit.github.io/lmfit-py/

В документации к библиотеке lmfit приведено большое количество примеров, приведем здесь их описание с целью облегчения поиска полезной информации:

Fit with Data in a pandas DataFrame - аппроксимация по данным содержащимся в pandas DataFrame (https://lmfit.github.io/lmfit-py/examples/example_use_pandas.html#sphx-glr-examples-example-use-pandas-py).

Using an ExpressionModel - использование модуля ExpressionModel для построение моделей с выражениями, определенными пользователем (https://lmfit.github.io/lmfit-py/examples/example_expression_model.html#sphx-glr-examples-example-expression-model-py).

Fit Using Inequality Constraint - использование ограничений типа неравенств (https://lmfit.github.io/lmfit-py/examples/example_fit_with_inequality.html#sphx-glr-examples-example-fit-with-inequality-py).

Fit Using differential_evolution Algorithm - пример использования алгоритма Differential_evolution (https://lmfit.github.io/lmfit-py/examples/example_diffev.html#sphx-glr-examples-example-diffev-py).

Fit Using Bounds - аппроксимация с использованием ограничений параметров (https://lmfit.github.io/lmfit-py/examples/example_fit_with_bounds.html#sphx-glr-examples-example-fit-with-bounds-py).

Fit Specifying Different Reduce Function - использование различных целевых функций минимизации (https://lmfit.github.io/lmfit-py/examples/example_reduce_fcn.html#sphx-glr-examples-example-reduce-fcn-py).

Building a lmfit model with SymPy - построение модели с использованием библиотеки символьных вычислений SymPy (https://lmfit.github.io/lmfit-py/examples/example_sympy.html#sphx-glr-examples-example-sympy-py).

Fit with Algebraic Constraint - аппроксимация с использованием алгебраических ограничений (https://lmfit.github.io/lmfit-py/examples/example_fit_with_algebraic_constraint.html#sphx-glr-examples-example-fit-with-algebraic-constraint-py).

Fit Multiple Data Sets - одновременная подгонка нескольких наборов данных (https://lmfit.github.io/lmfit-py/examples/example_fit_multi_datasets.html#sphx-glr-examples-example-fit-multi-datasets-py).

Fit using the Model interface - использование класса Model (https://lmfit.github.io/lmfit-py/examples/example_Model_interface.html#sphx-glr-examples-example-model-interface-py).

Fit Specifying a Function to Compute the Jacobian - аппроксимация с указанием аналитической функции для вычисления якобиана (для ускорения вычислений) (https://lmfit.github.io/lmfit-py/examples/example_fit_with_derivfunc.html#sphx-glr-examples-example-fit-with-derivfunc-py).

Outlier detection via leave-one-out - обнаружение выбросов методом исключения одного наблюдения (https://lmfit.github.io/lmfit-py/examples/example_detect_outliers.html#sphx-glr-examples-example-detect-outliers-py).

Emcee and the Model Interface - использование алгоритма emcee (https://lmfit.github.io/lmfit-py/examples/example_emcee_Model_interface.html#sphx-glr-examples-example-emcee-model-interface-py). Алгоритм emcee может быть использован для получения апостериорного распределения вероятностей параметров, заданного набором экспериментальных данных, он исследует пространство параметров, чтобы определить распределение вероятностей для параметров, но без явной цели попытаться уточнить решение. Его не следует использовать для аппроксимации, но это полезный метод для более тщательного изучения пространства параметров вокруг решения, он позволяет получить лучшее понимание распределения вероятности для параметров; см. также https://emcee.readthedocs.io/en/stable/.

Complex Resonator Model - в примере показано, как показано, как подобрать параметры сложной модели (резонатора) с помощью lmfit.Model и определения пользовательского класса Model (https://lmfit.github.io/lmfit-py/examples/example_complex_resonator_model.html#sphx-glr-examples-example-complex-resonator-model-py).

Model Selection using lmfit and emcee - в примере показано, как можно использовать алгоритм emcee для выбора байесовской модели (https://lmfit.github.io/lmfit-py/examples/lmfit_emcee_model_selection.html#sphx-glr-examples-lmfit-emcee-model-selection-py).

Calculate Confidence Intervals - расчет доверительных интервалов (https://lmfit.github.io/lmfit-py/examples/example_confidence_interval.html#sphx-glr-examples-example-confidence-interval-py).

Fit Two Dimensional Peaks - в примере показано, как обрабатывать двумерные данные с двухмерными распределениями вероятностей (https://lmfit.github.io/lmfit-py/examples/example_two_dimensional_peak.html#sphx-glr-examples-example-two-dimensional-peak-py).

Global minimization using the brute method (a.k.a. grid search) - глобальная минимизация методом brute (он же поиск по сетке) (https://lmfit.github.io/lmfit-py/examples/example_brute.html#sphx-glr-examples-example-brute-py).

Примеры из документации (Examples from the documentation):

Cоздание и сохранение модели в файл *.sav:

doc_model_savemodel.py (https://lmfit.github.io/lmfit-py/examples/documentation/model_savemodel.html#sphx-glr-examples-documentation-model-savemodel-py)

doc_model_savemodelresult.py (https://lmfit.github.io/lmfit-py/examples/documentation/model_savemodelresult.html#sphx-glr-examples-documentation-model-savemodelresult-py)

doc_model_savemodelresult2.py (https://lmfit.github.io/lmfit-py/examples/documentation/model_savemodelresult2.html#sphx-glr-examples-documentation-model-savemodelresult2-py)

Загрузка модели из файла *.sav:

doc_model_loadmodelresult.py (https://lmfit.github.io/lmfit-py/examples/documentation/model_loadmodelresult.html#sphx-glr-examples-documentation-model-loadmodelresult-py)

doc_model_loadmodelresult2.py (https://lmfit.github.io/lmfit-py/examples/documentation/model_loadmodelresult2.html#sphx-glr-examples-documentation-model-loadmodelresult2-py)

doc_model_loadmodel.py (https://lmfit.github.io/lmfit-py/examples/documentation/model_loadmodel.html#sphx-glr-examples-documentation-model-loadmodel-py)

Создание отчетов:

doc_fitting_withreport.py (https://lmfit.github.io/lmfit-py/examples/documentation/fitting_withreport.html#sphx-glr-examples-documentation-fitting-withreport-py)

Работа с доверительными интервалами:

doc_confidence_basic.py (https://lmfit.github.io/lmfit-py/examples/documentation/confidence_basic.html#sphx-glr-examples-documentation-confidence-basic-py)

построение доверительного интервала для кривой Гаусса doc_model_uncertainty.py (https://lmfit.github.io/lmfit-py/examples/documentation/model_uncertainty.html#sphx-glr-examples-documentation-model-uncertainty-py)

doc_confidence_advanced.py (https://lmfit.github.io/lmfit-py/examples/documentation/confidence_advanced.html#sphx-glr-examples-documentation-confidence-advanced-py)

Аппроксимация вероятностных распределений:

распределение Гаусса - doc_model_gaussian.py (https://lmfit.github.io/lmfit-py/examples/documentation/model_gaussian.html#sphx-glr-examples-documentation-model-gaussian-py)

смесь распределения Гаусса и линейной зависимости - doc_model_two_components.py (https://lmfit.github.io/lmfit-py/examples/documentation/model_two_components.html#sphx-glr-examples-documentation-model-two-components-py)

Различные опции lmfit:

doc_model_with_nan_policy.py (https://lmfit.github.io/lmfit-py/examples/documentation/model_with_nan_policy.html#sphx-glr-examples-documentation-model-with-nan-policy-py)

doc_model_with_iter_callback.py (https://lmfit.github.io/lmfit-py/examples/documentation/model_with_iter_callback.html#sphx-glr-examples-documentation-model-with-iter-callback-py)

doc_parameters_basic.py (https://lmfit.github.io/lmfit-py/examples/documentation/parameters_basic.html#sphx-glr-examples-documentation-parameters-basic-py)

doc_parameters_valuesdict.py (https://lmfit.github.io/lmfit-py/examples/documentation/parameters_valuesdict.html#sphx-glr-examples-documentation-parameters-valuesdict-py)

Использование различных встроенных моделей:

ступенчатая аппроксимация doc_builtinmodels_stepmodel.py (https://lmfit.github.io/lmfit-py/examples/documentation/builtinmodels_stepmodel.html#sphx-glr-examples-documentation-builtinmodels-stepmodel-py), doc_model_composite.py (https://lmfit.github.io/lmfit-py/examples/documentation/model_composite.html#sphx-glr-examples-documentation-model-composite-py)

смесь двух гауссовых и экспоненциального распределения: doc_builtinmodels_nistgauss.py (https://lmfit.github.io/lmfit-py/examples/documentation/builtinmodels_nistgauss.html#sphx-glr-examples-documentation-builtinmodels-nistgauss-py), doc_builtinmodels_nistgauss2.py (https://lmfit.github.io/lmfit-py/examples/documentation/builtinmodels_nistgauss2.html#sphx-glr-examples-documentation-builtinmodels-nistgauss2-py)

модели с пиками (распределения Гаусса и Коши-Лоренца ) doc_builtinmodels_peakmodels.py (https://lmfit.github.io/lmfit-py/examples/documentation/builtinmodels_peakmodels.html#sphx-glr-examples-documentation-builtinmodels-peakmodels-py)

сплайны doc_builtinmodels_splinemodel.py (doc_builtinmodels_splinemodel.py)

обзор различных возможностей (смесь распределений, дверительные интервалы, графики и т.д.) doc_model_uncertainty2.py (https://lmfit.github.io/lmfit-py/examples/documentation/model_uncertainty2.html#sphx-glr-examples-documentation-model-uncertainty2-py)

алгортим emcee doc_fitting_emcee.py (https://lmfit.github.io/lmfit-py/examples/documentation/fitting_emcee.html#sphx-glr-examples-documentation-fitting-emcee-py)

Вначале рассмотрим различные приемы аппроксимации в lmfit:

пример 1 - аппроксимация с использованием интерфейса Model (самый простой случай);

пример 2 - аппроксимация с использованием интерфейса Model и объекта класса Parameter, расчетом доверительных интервалов;

пример 3 - аппроксимация с использованием функции minimize;

пример 4 - аппроксимация c использованием объекта класса Minimazer.

Затем рассмотрим различные частные случаи аппроксимации в lmfit:

пример 5 - аппроксимация с заданием начальных значений (initial values) (на примере экспоненциальной зависимости I типа);

пример 6 - аппроксимация c использованием встроенных моделей библиотеки lmfit;

пример 7 - аппроксимация c использованием методов глобального поиска;

пример 8 - обнаружение выбросов (outlier detection) при аппроксимации

Пример 1 - аппроксимация с использованием интерфейса Model (самый простой случай)

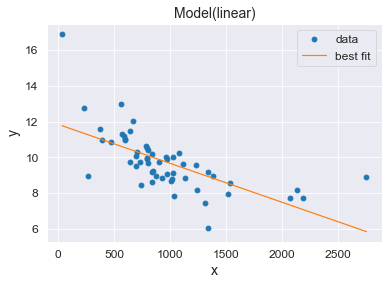

Для начала рассмотрим самую обычную аппроксимацию на примере линейной зависимости, для подгонки параметров модели используем метод fit класса Model.

Пояснения к расчету:

Вначале исходные данные - двумерную таблицу (X1, Y) - приводим к виду, отсортированному по возрастанию переменной X1, для того, чтобы встроенные графические возможности библиотеки lmfit корректно отображали информацию.

С помощью lmfit.Model создаем модель.

С помощью model.fit выполняем аппроксимацию (нахождение параметров). По умолчанию используется алгоритм Левенберга-Марквардта (Levenberg–Marquardt algorithm) (leastsq, least_squares).

С помощью result.fit_report выводим отчет с результатами, который содержит:

метрики качества аппроксимации: chi-square - в данном случае сумма квадратов остатков

(т.е. по сути SSE), reduced chi-square

и

;

информационные критерии Акаике и Байеса;

параметры модели

и

с их стандратными ошибками, относительными ошибками в % и начальными условиями (init);

коэффициенты корреляции между параметрами C(b0, b1).

Выводим различные виды графиков:

result.plot_fit() - обычный точечный график;

result.plot_residuals() - график остатков;

result.plot() - точечный график, совмещенный с графиком остатков.

import lmfit

print('{:<35}{:^0}'.format("Текущая версия модуля lmfit: ", lmfit.__version__), '\n')

# Preparation of input data

dataset_sort_df = dataset_df.loc[:, ['X1', 'Y']].sort_values(by=['X1'])

#display(dataset_sort_df)

Y_sort = np.array(dataset_sort_df['Y'])

#print(Y_sort, type(Y_sort), len(Y_sort))

X_sort = np.array(dataset_sort_df['X1'])

#print(X_sort, type(X_sort), len(X_sort))

# LINEAR MODEL

func_name = 'linear'

print(f'{func_name.upper()} MODEL: {formulas_dict[func_name]}')

func = models_dict[func_name]

p0 = p0_dict[func_name]

model = lmfit.Model(func, independent_vars=['x'], name=func_name)

result = model.fit(Y_sort, x=X_sort, b0=p0[0], b1=p0[1])

print(result.fit_report())

result.plot_fit()

plt.show()

result.plot_residuals()

plt.show()

result.plot()

plt.show()

Текущая версия модуля lmfit: 1.1.0

LINEAR MODEL: y = b0 + b1*x

[[Model]]

Model(linear)

[[Fit Statistics]]

# fitting method = leastsq

# function evals = 7

# data points = 55

# variables = 2

chi-square = 84.4203915

reduced chi-square = 1.59283758

Akaike info crit = 27.5661686

Bayesian info crit = 31.5808350

R-squared = 0.42259718

[[Variables]]

b0: 11.8501350 +/- 0.37396000 (3.16%) (init = 0)

b1: -0.00217603 +/- 3.4938e-04 (16.06%) (init = 0)

[[Correlations]] (unreported correlations are < 0.100)

C(b0, b1) = -0.890

Пример 2 - аппроксимация с использованием интерфейса Model и объекта класса Parameter, расчетом доверительных интервалов

Рассмотрим аппроксимацию с более широким использованием возможностей библиотеки lmfit на примере степенной зависимости:

используем объект класса Parameter для задания свойств параметров модели;

выведем дополнительные отчеты;

выполним расчет доверительного интервала (подробнее см. https://lmfit.github.io/lmfit-py/confidence.html#lmfit.conf_interval, https://lmfit.github.io/lmfit-py/examples/example_confidence_interval.html#sphx-glr-examples-example-confidence-interval-py, https://lmfit.github.io/lmfit-py/examples/documentation/confidence_advanced.html#sphx-glr-examples-documentation-confidence-advanced-py)).

Пояснения к расчету:

Исходные данные также должны быть отсортированы по возрастанию переменной X1.

Также с помощью lmfit.Model создаем модель.

С помощью model.make_params задаем свойства параметров модели (в этом примере мы просто задаем начальные значения параметров, не затрагивая прочие атрибуты - минимальные и максимальные значения, алгебраические ограничения и т.д.).

Также с помощью model.fit выполняем аппроксимацию (нахождение параметров), при этом расширим набор используемых настроек - добавим method и nan_policy (правда, значения установим по умолчанию leastsq и raise).

Также с помощью result.fit_report выводим отчет с результатами, при этом установим ограничение на коэффициент корреляции между параметрами (min_correl=0.2).

С помощью result.params.pretty_print() выведем отчет о параметрах модели.

С помощью result.ci_report() выведем отчет о границах доверительных интервалов для параметров модели.

С помощью result.eval_components и result.eval выведем расчетные значения модели: в первом случае - в виде словаря (dict), во-втором случае - в виде массива (numpy.ndarray).

С помощью result.eval_uncertainty выведем ширину доверительного интервала для расчетных значений.

По аналогии с предыдущим примером выведем графики result.plot_fit() и result.plot_residuals() с настройкой их атрибутов (размер окна, подписи осей и пр.).

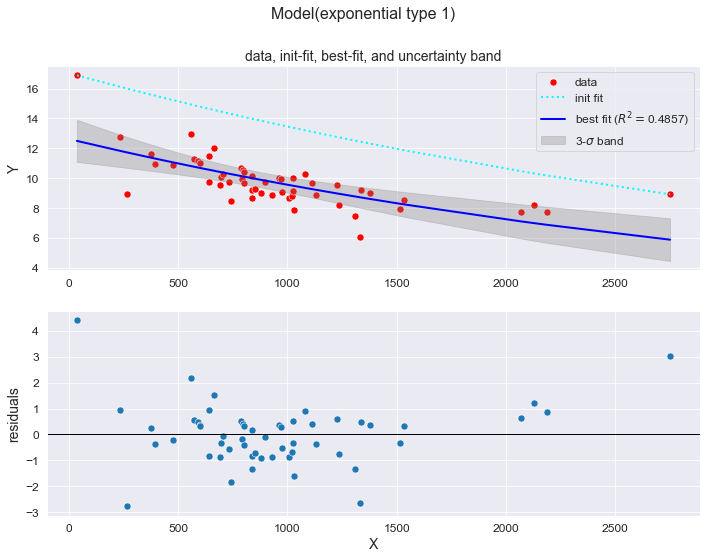

Дополнительно выведем графики двух видов:

на первом графике будут отображаться фактические данные (data), расчетные данные по модели аппроксимации (best fit) и также доверительный интервал шириной

;

на втором графике будет отображаться остатки (residuals).

Замечание касательно расчета доверительных интервалов: для отдельных моделей lmfit может выдавать ошибку Cannot determine Confidence Intervals without sensible uncertainty estimates, в этом случае необходимо установить пакет numdifftools (https://pypi.org/project/numdifftools/).

# POWER MODEL

func_name = 'power'

print(f'{func_name.upper()} MODEL: {formulas_dict[func_name]}')

# define objective function

func = models_dict[func_name]

# initial values

p0 = p0_dict[func_name]

# create a Model

model = lmfit.Model(func,

independent_vars=['x'],

name=func_name)

# create a set of Parameters

params = model.make_params(b0=p0[0],

b1=p0[1])

# calculations

result = model.fit(Y_sort, params, x=X_sort,

method='leastsq',

nan_policy='raise')

# report of the fitting results (https://lmfit.github.io/lmfit-py/model.html#lmfit.model.ModelResult.fit_report)

print(f'result.fit_report:\n{result.fit_report(min_correl=0.2)}\n')

# report of parameters data (https://lmfit.github.io/lmfit-py/parameters.html#lmfit.parameter.Parameters.pretty_print)

print('result.params.pretty_print():')

result.params.pretty_print()

print('\n')

# report of the confidence intervals (https://lmfit.github.io/lmfit-py/confidence.html#lmfit.ci_report)

print(f'result.ci_report:\n{result.ci_report()}\n')

# evaluate each component of a composite model function (https://lmfit.github.io/lmfit-py/model.html#lmfit.model.ModelResult.eval_components)

comps = result.eval_components(x=X_sort)

print(f'result.eval_components = \n{comps}\n')

# evaluate the uncertainty of the model function (https://lmfit.github.io/lmfit-py/model.html#lmfit.model.ModelResult.eval_uncertainty)

dely = result.eval_uncertainty(sigma=3)

print(f'result.eval_uncertainty(sigma=3) = \n{dely}\n')

# graphic (data, best-fit, uncertainty band and residuals)

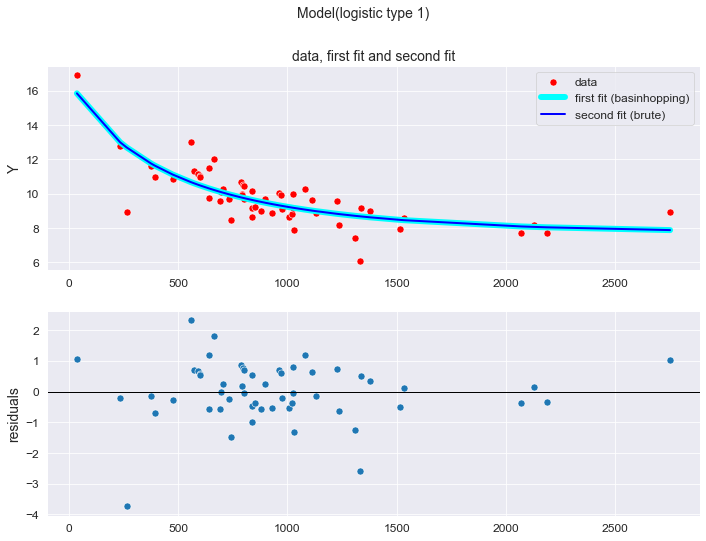

fig, axes = plt.subplots(2, 1, figsize=(297/INCH, 210/INCH))

fig.suptitle(f'Model({func_name})', fontsize=16)

#label = func_name + ' '+ r'$(R^2 = $' + f'{R2}' + ', ' + f'RMSE = {RMSE}' + ', ' + f'MAE = {MAE}' + ', ' + f'MSPE = {MSPE}' + ', ' + f'MAPE = {MAPE})'

axes[0].set_title('data, best-fit, and uncertainty band')

sns.scatterplot(x=X_sort, y=Y_sort, label='data', s=50, color='red', ax=axes[0])

R2 = round(result.rsquared, DecPlace)

sns.lineplot(x=X_sort, y=result.best_fit, color='blue', linewidth=2, legend=True, label='best fit (' + r'$R^2 = $' + f'{R2})', ax=axes[0])

axes[0].fill_between(X_sort, result.best_fit-dely, result.best_fit+dely, color="grey", alpha=0.3, label=r'3-$\sigma$ band')

axes[0].legend()

axes[0].set_ylabel('Y')

#axes[0].set_xlim(X1_min_graph, X1_max_graph)

#axes[0].set_ylim(Y_min_graph, Y_max_graph)

sns.scatterplot(x=X_sort, y=-result.residual, ax=axes[1], s=50)

axes[1].axhline(y = 0, color = 'k', linewidth = 1)

axes[1].set_xlabel('X')

axes[1].set_ylabel('residuals')

#axes[1].set_xlim(X1_min_graph, X1_max_graph)

#axes[1].set_ylim(Y_min_graph, Y_max_graph)

plt.show()POWER MODEL: y = b0*x^b1

result.fit_report:

[[Model]]

Model(power)

[[Fit Statistics]]

# fitting method = leastsq

# function evals = 29

# data points = 55

# variables = 2

chi-square = 49.8796865

reduced chi-square = 0.94112616

Akaike info crit = -1.37456420

Bayesian info crit = 2.64010217

R-squared = 0.65884224

[[Variables]]

b0: 33.4032965 +/- 3.45275807 (10.34%) (init = 0)

b1: -0.18409814 +/- 0.01572801 (8.54%) (init = 0)

[[Correlations]] (unreported correlations are < 0.200)

C(b0, b1) = -0.992

result.params.pretty_print():

Name Value Min Max Stderr Vary Expr Brute_Step

b0 33.4 -inf inf 3.453 True None None

b1 -0.1841 -inf inf 0.01573 True None None

result.ci_report:

99.73% 95.45% 68.27% _BEST_ 68.27% 95.45% 99.73%

b0: -9.61176 -6.50967 -3.33032 33.40330 +3.57568 +7.51972 +11.99711

b1: -0.04701 -0.03103 -0.01551 -0.18410 +0.01594 +0.03283 +0.05128

result.eval_components =

{'power': array([17.1825, 12.2259, 11.9584, 11.2070, 11.1216, 10.7403, 10.4265,

10.3691, 10.3104, 10.2881, 10.2818, 10.1608, 10.1608, 10.0915,