Прежде чем перейти к статье, хочу вам представить, экономическую онлайн игру Brave Knights, в которой вы можете играть и зарабатывать. Регистируйтесь, играйте и зарабатывайте!

Из предыдущего поста вы узнали, что в ML существует дискриминация. Отлично! Таким образом вы уже разбираетесь в Этике машинного обучения лучше, чем многие инженеры МL. Благодаря примерам (из медицины, анализа твиттов, распознавания лиц) вы наверняка уже сделали вывод, что существуют разные виды предвзятости.

Алгоритмы машинного обучения строят стереотипы на основе каких-либо черт и особенностей, так же как это делаем и мы с вами.

Три кита дискриминации

Есть три характеристики людей, на которых основываются большинство предвзятостей в real-world алгоритмах:

Гендер

Раса

Возраст

Дискриминация может быть против многих характеристик (доход, образование, и т.д.), вытекающих из указанных выше. В алгоритмах, которые работают с людскими данными, ими в основном являются доход, место проживания, образование и т.д.

Одним словом: практически всё, к чему обычный человек может проявить дискриминацию. Эти характеристики называют чувствительными атрибутами (sensitive attributes) — особенности, по отношению которых проявляется дискриминация.

Набор данных, по которым обучается модель машинного обучения, имеет конкретные признаки (features). Признаки (или атрибуты) являются одной из основных причин, почему существует предвзятость в алгоритмах машинного обучения.

Важно будет отметить, что самой модели машинного все равно на то, против чего дискриминировать. Это может быть цвет стебля у растения, глубина глазниц, город рождения кота и так далее. Современные модели не обладают возможностями к мышлению, а являются просто продвинутым инструментом анализа данных.

Если задуматься, то всё кажется вполне очевидным: модель, которая фактически работает за счёт запоминания закономерностей из данного набора данных (а эти данные отражают стереотипы людей), будет наверняка помнить эти не всегда справедливые (или стереотипичные) закономерности и начнёт использовать их для прогнозов.

Примеры дискриминации по половому признаку из алгоритмов машинного обучения:

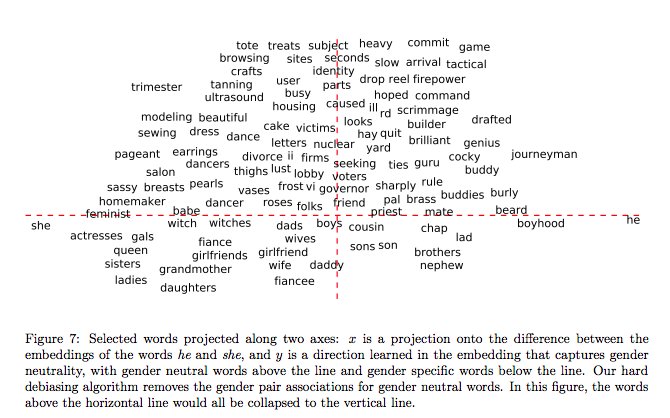

Word embeddings, полученные из статьей с Google News (где материал довольно строго курируется), отражают большое количество гендерных стереотипов («Man is to Computer Programmer as Woman is to Homemaker»)

Точность алгоритмов распознавания лица «IBM’s» и «Face++» значительно ниже для женщин по сравнению с мужчинами («Gender Shades»)

Некоторые алгоритмы допускают серьёзные погрешности во время перевода женского голоса в текст ( «Where is Female Synthetic Speech»).

Предвзятость, связанная с расой, очень удручает многих специалистов в области технологий. Пару лет назад некоторые американские клиники предоставляли темнокожим пациентам почти в два раза меньше средств для специальной медицинской помощи. Используемый алгоритм предсказывал, что темнокожие меньше нуждались в особом наблюдении (https://science.sciencemag.org/content/366/6464/447.abstract) Другой алгоритм, COMPAS, который использовали в американских судах, выдавал в два раза больше ложноположительных (false positive) прогнозов о рецидивизме по отношению к темнокожим, нежели к светлокожим. (https://www.propublica.org/article/how-we-analyzed-the-compas-recidivism-algorithm) Есть еще масса примеров bias’а, который основывается на расе.

Так почему это происходит?

Потому что используются реальные данные о людях и их исходах. Если многие чернокожие на самом деле оказались рецидивистами, эта закономерность запоминается («Чёрные люди с большей вероятностью снова совершат преступление»). Алгоритм не берёт во внимание какие-либо особые обстоятельства, предысторию и прочие элементы трагической жизни индивидуума. А должен ли он? При этом в случаях, в которых алгоритм ущемляет определенные группа из-за социальных стереотипов (как в примере с корпусом слов), он по прежнему является объективным в рамках предоставленных ему данных.

Большинство алгоритмов машинного обучения делают то, что им “говорят” данные и статистические методы. Проще говоря, учатся на прошлом опыте: на объективных данных.

Поэтому возникает вопрос: так разве можно утверждать, что результаты, полученные с помощью такого (объективного) подхода, несправедливы?

Это и есть дилемма этики в ИИ: по мере того, как мы пытаемся стереть грань между человеческим мозгом и «мозгом» искусственного интеллекта, необходимо также определить грань между этическими и нравственными их составляющими.