Вторым после серверов по важности элементом построения современного дата-центра, являются системы хранения. В концепции Open Compute Project хранение данных следует общей идее минимизации функционала реализованного на уровне железа и ориентируется на Software Defined Everything технологии. Поэтому большое распространение получили массивы-экстендеры JBOD (Just a Bunch Of Discs) и JBOF (Just a Bunch Of Flash). Такие массивы присоединяются непосредственно к серверу и предоставляют диски в его операционную систему непосредственно по интерфейсу SAS или шине PCIe и не имеют контроллера, управляющего хранением.

Рост использования таких дисковых массивов JBOD/JBOF произошел в связи с широким распространением систем программно-определяемого хранения и гиперконвергенции. За счет увеличения дискового объема на одном сервере, получается добиться оптимального соотношения вычислительной мощности и объема хранения и достичь сопоставимых с традиционными системами хранения данных показателей производительности и лучших показателей по стоимости на один терабайт, сохраняя при этом нужную степень надежности.

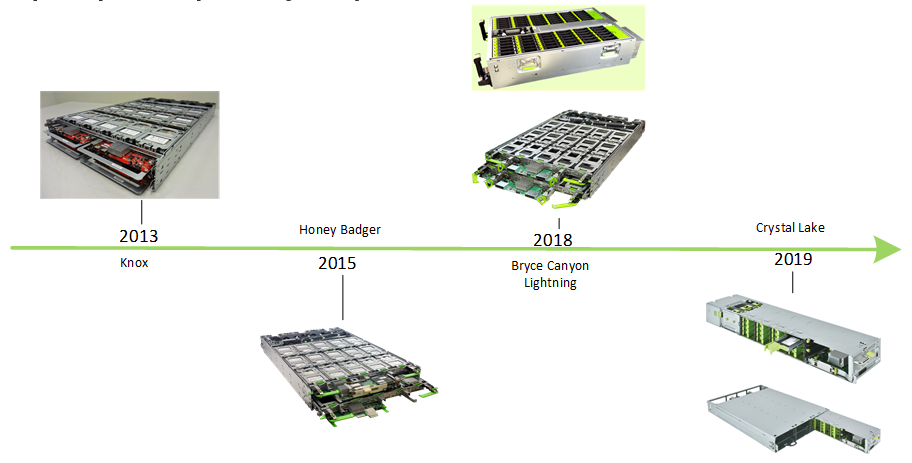

В рамках OCP первые дисковые массивы появились в 2013 году и с тех пор претерпели несколько этапов изменений.

2013 год

Knox JBOD

Knox (или как его еще называют Open Vault) был выпущен в 2013 году. Это дисковая полка JBOD. Массив состоит из двух лотков по 15 дисков формата 3.5”. Как и все оборудование формата OCP обслуживается с передней панели, за исключением вентиляторов, замена которых может быть выполнена только из горячего коридора сзади стойки. Для доступа к дискам внутри лотка необходимо освободить зацепы и потянуть полку на себя, открыв доступ к индивидуальным дисковым ячейкам. Также для удобства обслуживания лотки имеют механизм-раскладушку для складывания лотка вниз. Данная функция особенно удобна при расположении массива дисков вверху стойки. Каждый лоток оборудован платой с двумя SAS экспандерами и платой управления шестью установленными вентиляторами. Благодаря экспандерам обеспечивается отказоустойчивый путь до каждого диска.

2015 год

Honey Badger

Honey Badger стал уже аналогом полноценной СХД. В нем появился микросервер-контроллер Panther+ на базе Intel Avoton SoC (C2350 и C2750) с четырьмя слотами DDR3 SODIMM и интерфейсами mSATA/M.2 SATA3. Сам же микросервер устанавливается в основную плату Honey Badger’а, которая в свою очередь уже имеет SAS контроллер, SAS экспандер, AST1250 BMC, два разъема miniSAS и слот для мезанинной карты OCP 10GbE.

2016 год

HatTrick

Дисковый массив JBOD, разработанный компанией Jabil (это один из крупнейших мировых ODM) в рамках линейки продуктов OCP под брендом Stack Velocity. Шасси массива представляют собой полку на 3 устройства для стоек OpenRack v1 и v2. Массив оснащен интерфейсом 12G SAS и вмещает в себя до 15 дисков 3.5". Сам массив поддерживает зонирование дисков. Так же на самом массиве расположен OCP Debug разъем. В этом продукте впервые появился удачный конструктив, похожий на сервера OCP Leopard и TiogaPass.

2018 год

Lightning JBOF

Первое устройство JBOF (Just a bunch of flash) OCP формата, работающее с дисками NVMe PCIe SSD. За основу был взят тот же Knox, так как форм-фактор уже был понятен, а вывод продукции на рынок сокращался. В эксплуатации появились новые платы:

PCIe retimer card – x16 PCIe gen3 карта, которая устанавливается в головной сервер. Карта PCIe retimer обеспечивает восстановление сигналов PCIe шины по mini-SAS HD кабелям при выносе устройств на 1,5 метра за пределы сервера.

PCIe Expansion Board (PEB) - На этой плате расположены PCIe switch и BMC контроллер. Одна плата PEB устанавливается на каждый лоток SSD накопителей и заменяет плату SAS Expander Board (SEB), используемую в Knox. Это позволяет использовать общую коммутационную плату для обоих лотков, а также позволяет легко проектировать новые или различные версии (например, с коммутаторами нового поколения), не изменяя остальную инфраструктуру. Каждая PEB имеет до 32x полос PCIe в качестве аплинка.

Bryce Canyon Storage System

Bryce Canyon разрабатывался для холодного архивного хранения с высокой плотностью и позволяет упаковать в объем 4OU 72 диска 3,5". Этот массив имеет 3 различных модели.

Первая модель работает как два раздельных NAS сервера благодаря двум установленным в него микросерверам-контроллерам SoC Mono Lake. I/O модуль, используемый в данной конфигурации, поддерживает два слота PCIe M.2 с четырьмя полосами PCIe Gen 3 в дополнение к мезанинной сетевой карте OCP. Каждому серверу доступны 36 дисков.

Для системы хранения с меньшими требованиями к производительности, но с большим объемом имеется версия массива с одним Mono Lake микросервером. В такой конфигурации все 72 диска доступны одной системе. Для доступа используется интерфейс 25GbE.

Третяя версия массива представляет собой простой дисковый SAS-экстендер JBOD на 72 диска 3.5", которые презентуются наружу посредством двух mini SAS HD портов 4x12G. На стороне управляющего сервера должен быть RAID HBA LSI SAS Megaraid 9480-8e или non-RAID HBA LSI SAS Megaraid 9300-8e.

Во всех исполнениях массив поддерживает «горячую» замену дисков. Каждый элемент в системе крепится на защелках или «барашковых» винтах. В центральной части массива под крышкой находятся кабеля питания в подвижном рукаве, что позволяет вынимать массив из стойки для обслуживания без отключения питания. Особенностью являются те же вентиляторы, замена которых может быть выполнена только из горячего коридора сзади стойки.

2019 год

Crystal Lake

В 2019 году компания MiTAC, известная своими брендами Mio и Tyan, представила дисковый массив Crystal Lake класса all-flash NVMe в форм-факторе похожем на современные сервера OCP TiogaPass. Шасси дискового массива занимает 2OU и вмещает в себя 3 массива, емкостью 16 NVMe дисков U.2 каждый. Таким образом одно шасси Crystal Lake суммарно вмещает 48 дисков. В настоящее время это самая высокая плотность размещения дисков U.2 в размере двух юнитов.

Подключение производится к головному серверу через всё тот же PCIe retimer card. Форм-фактор массива похож на формфактор современных серверов OCP TiogaPass, что очень удобно при компоновке высокоплотных решений в серверной стойке, так как массив можно секционировать на 2 или 4 части. Текущая версия массива поддерживает PCIe gen3, но заявлены планы на реализацию PCIe gen 4. Внутри шасси расположена шина питания со скользящими контактами. Это позволяет вынимать дисковый массив из шасси без отключения питания для замены дисков, обслуживания или просмотра индикации LED. При открытии массива автоматически запускается режим повышенного охлаждения для компенсации изменившихся условий воздушного потока - вентиляторы переводятся в режим максимальных оборотов. Сами вентиляторы, в отличие от всех предыдущих моделей дисковых массивов, заменяются с фронтальной стороны стойки из холодного коридора. Управление и мониторинг массива обеспечиваются OpenBMC с удобным WEB-интерфейсом. Так же реализована поддержка Red Fish.

Stay tunned...

Назад, в историю серверов OCP